Parmi les sources d’énergie que la nature nous propose, il reste un champ entier non encore exploité : celui de la fusion nucléaire. Qu’en est-il réellement en 2021 de ses promesses, et de sa réalité ? La domestication de l’énergie des étoiles va-t-elle entrer, quand et comment, dans la grande équation de la croissance durable ? Est-ce possible, utile, souhaitable ?

Le 21ème siècle, cela parait inéluctable, devra faire face à un défi majeur en matière de population et de production d’énergie. Il faut donc désormais réconcilier le besoin légitime d’uniformisation du niveau de vie moyen de l’humanité et la préservation d’un environnement toujours plus pillé et souillé par la production d’énergie, moteur-même de la croissance (Lire : La transition énergétique, enjeu majeur pour la planète).

Le compte à rebours de cette catastrophe annoncée peut-il être stoppé, et si oui comment ? Il semble clair qu’il n’y aura pas de réponse simple, et surtout rapide, à cette question. Tous les rouages de la société doivent être profondément revisités, et sollicités systématiquement. La véritable pandémie climatique qui s’annonce au cours de ce siècle balaiera sur son passage, c’est certain, le monde d’avant. Pour ne pas céder au catastrophisme ou à la panique, tous deux contre-productifs, il faut combiner dès maintenant toutes les solutions et actionner tous les leviers disponibles, donc commencer par se débarrasser des querelles partisanes qui ferment des portes et font prendre du retard (Lire : L’électricité dans le mix énergétique mondial : dynamique d’évolution et interprétations).

Même si l’on note aujourd’hui une défiance claire liée à leur utilisation parfois inconséquente, la science et la technologie restent un levier majeur du combat, au côté des leviers politiques, éducationnels et comportementaux bien entendu (Lire : Énergie et collectivités locales : le témoignage d’un élu). Et même si les échelles de temps ou de moyens pour des solutions innovantes semblent souvent significatifs, voire énormes, on se doit de continuer à explorer toutes les sources d’énergie possibles avec le plus haut niveau d’exigence, d’excellence et de conscience sociétales. Dans ce registre, la science doit non seulement ouvrir son champ de recherche aux sources d’énergie, mais également à toutes les technologies visant à optimiser son stockage, son transport, son utilisation et à en contrecarrer les nuisances. La fermeture du cycle du combustible de la fission nucléaire, ou le piégeage du CO2, restent des champs encore trop peu explorés (Lire : Captage et stockage du carbone).

1. L’énergie nucléaire, composante des futurs mix énergétiques durables ?

Le 20ème siècle a vu l’humanité découvrir, comprendre puis utiliser la force de cohésion du noyau de l’atome. Mais d’où vient cette force ? Quels sont ses rapports avec l’environnement ?

1.1. Un concentré incomparable d’énergie

Cette étape historique venait à la suite d’une succession de découvertes, aussi vieilles que l’humanité pour certaines, visant à la démultiplication de la capacité énergétique de chaque individu, au-delà de sa simple force physique propre. L’homme a ainsi d’abord tiré parti de l’énergie mécanique, en attelant des animaux à des outils agraires ou de transport, puis de l’énergie chimique, celle du feu, qui consume les composés carbonés tels que le bois, le gaz et le pétrole, en produisant de la chaleur ou du travail mécanique. C’est ainsi qu’il est passé de sa préhistoire à l’ère de la révolution industrielle, dans une évolution régulière mais lente de plusieurs milliers d’années (Lire : La consommation mondiale d’énergie avant l’ère industrielle).

Puis en l’espace de quelques dizaines d’années tout s’est accéléré grâce à deux découvertes majeures. La première est celle de l’électricité, qui révolutionna totalement la manière de transporter et de consommer l’énergie, donc de la gérer à l’échelle d’une population (Lire : Histoire de l’électricité). La seconde découverte est celle de la radioactivité, révélatrice de ce qui allait mener à une augmentation considérable de l’efficacité de production de cette même électricité : l’énergie nucléaire (Lire : L’énergie nucléaire : une brève histoire).

L’énergie nucléaire concentre en effet de l’ordre d’un million de fois plus d’énergie par réaction que l’énergie chimique de combustion. Par l’expérience menée en 1934, bombardant des atomes totalement stables avec des particules alpha émises par une source radioactive naturellement, Irène et Frédéric Joliot-Curie découvrent qu’ils induisent une nouvelle radioactivité, qui perdure même si l’on éloigne la source de rayonnement alpha initiale (figure 1).

Figure 1. Irène et Frédéric Joliot-Curie. [Source : GFHund, CC BY 3.0, via Wikimedia Commons]

Cette radioactivité induite va ouvrir en moins de dix ans le chemin vers la mise au point et la maitrise de réactions nucléaires en chaîne, dans des matériaux irradiés par des neutrons et capables eux-mêmes de se désintégrer en émettant à nouveau des neutrons (Lire : Les réacteurs nucléaires). La densité volumique de puissance de telles sources dépasse de très loin toute source d’énergie connue jusque-là, promesse de croissance et, dans les années 1970-80 pour un pays comme la France, d’indépendance énergétique vis-à-vis d’un pétrole très inégalement réparti sur le globe.

1.2. Exploser ou confiner ?

L’Histoire a voulu que cette découverte de l’énergie de fission du noyau des atomes coïncide avec la seconde guerre mondiale, et qu’elle se transforme en une course effrénée à la mise au point de bombes, avec ses deux points d’orgues macabres du 6 et du 9 août 1945 à Hiroshima et Nagasaki (figure 2).

Ce fut la démonstration terrible de la capacité à enclencher les réactions nucléaires, et de les laisser évoluer volontairement sans les maitriser. La course à la puissance militaire se trouvait un nouveau champion : la bombe A, très vite rejoint et dépassé dès 1952 par un second champion : la bombe H (Lire : La non-prolifération des armes nucléaires).Cette seconde bombe tire également partie de l’énergie de cohésion des constituants du noyau atomique, les protons et les neutrons, mais si la fission des noyaux dits lourds, tels l’uranium, libère de l’énergie, la fusion des noyaux légers tels l’hydrogène en libère encore plus. A noter que dans le tableau périodique des éléments de Mendeleïev, la séparation entre noyaux légers et lourds se situe au niveau du noyau de l’atome de Fer.

Ces découvertes conduites dans un cadre militaire ont ouvert également une nouvelle voie de recherche, celle du contrôle de telles réactions, de fission ou de fusion, à des fins cette fois pacifiques, mais néanmoins économiques et commerciales : la production contrôlée de chaleur, et donc potentiellement de très grandes quantités d’électricité de manière très concentrée.

Or si le confinement de réactions de fission nucléaire a très rapidement trouvé ses technologies, la production et la maitrise des réactions de fusion en est encore aux démonstrations de faisabilité, pour des raisons, à la fois scientifiques et technologiques, d’établissement et de maintien des conditions sine qua non au déclenchement et au maintien de telles réactions sur terre.

1.3. Une médaille environnementale à trois faces

Sauf à se passer complètement de sources d’énergie en soutien à l’activité et au développement de nos sociétés, il est clair que l’activité humaine impacte l’environnement (Lire : L’environnement dans les politiques de l’énergie).

L’équation qui régit cet impact contient essentiellement trois termes majeurs.

Avant qu’une source quelconque d’énergie soit prête à fonctionner, son premier impact renvoie à son approvisionnement, qui compte à la fois en matières premières et en énergie dépensée pour les mettre à disposition. Le pétrole, vecteur important de l’énergie chimique, requiert son extraction du sous-sol qu’il menace d’épuisement, ce type de ressource naturelle nécessitant des millions d’années pour se (re)constituer (Lire : Géologie et géodynamique des hydrocarbures). De plus, la consommation toujours croissante de cette ressource s’accompagne de besoins de forages de plus en plus profonds et complexes, et donc de plus en plus coûteux en énergie. Si au début de l’exploitation pétrolière, certains gisements étaient affleurant et ne nécessitaient quasiment aucune énergie pour la collecte du pétrole, ce n’est plus du tout le cas de nos jours. Le coût d’extraction du baril de pétrole couvre désormais une fraction notable du prix-même de ce baril. Le pétrole, une fois extrait, doit ensuite être transporté puis raffiné avant de pouvoir être prêt à être brûlé. L’ensemble de cet « amont » de la filière constitue donc un impact environnemental très important, avec deux aspects non « durables » que sont l’épuisement des réserves et une forte production de gaz à effet de serre (GES) dès la phase de raffinement.

Le second terme de l’équation énergie-environnement couvre celui de la production même de l’énergie. Après plusieurs décennies précieuses perdues en tergiversations et lobbying, nul ne conteste plus que la combustion du gaz ou du charbon produit des quantités de dioxyde de carbone, de dioxyde de soufre, ainsi que de divers composés azotés et des microparticules, plus importantes que les océans ou les forêts ne peuvent absorber ou recycler et que les accumulations de gaz à effet de serre dans l’atmosphère conduisent à un dérèglement climatique non contrôlé à l’heure actuelle (Lire : Énergie et climat, les politiques climatiques). C’est principalement cet aspect qui bouleverse désormais le débat public sur les énergies, et propulse sur le devant de la scène des solutions a priori moins génératrices de tels gaz, comme l’énergie solaire, hydroélectrique ou éolienne. L’énergie nucléaire fait clairement partie de ce groupe.

Le dernier facteur-clé des relations entre la production d’énergie et l’environnement est enfin la question de l’aval de la production, donc des « déchets ». On peut inclure également dans ce chapitre la question du stockage par des « batteries ». En effet l’énergie, si elle n’est pas consommée une fois produite, se stocke difficilement. Soit l’on accumule de la chaleur dans des fluides caloporteurs (Lire : La gazéification) soit de l’électricité dans des batteries. Dans le second cas en particulier, l’impact actuel sur l’environnement peut se révéler à terme très négatif, car les technologies disponibles actuellement font appel à de grandes quantités de minerais rares, et sont fournis par une industrie souvent très polluante. Mais ce chapitre englobe également tous les déchets de fin de vie et de déconstruction des usines de production d’énergie, que ce soit les panneaux photovoltaïques en fin de vie, les matériaux divers des éoliennes ou des centrales de toute filière, ou tous produits de réactions ou activés dans les centrales nucléaires (Lire : Le stockage des déchets nucléaires).

Qu’en est-il de la fusion nucléaire qui se veut compétitive simultanément sur les trois termes de l’équation environnementale ? Elle se base en effet à la fois sur une abondance des composants de la réaction génératrice d’énergie, sur l’absence de production de gaz à effet de serre dans la phase de production même de l’énergie, et sur l’absence de production de déchets nucléaires à haute activité et/ou longue vie devant être gérés en fin de cycle (Lire : La gestion des déchets nucléaires). C’est bien ce triptyque gagnant qui motive les recherches en fusion nucléaire depuis plusieurs décennies et qui, malgré les défis scientifiques et technologiques majeurs, et malgré les échelles de temps longues encore avant sa commercialisation, justifient l’effort mondial concerté et unique[1].

2. Maitriser et domestiquer les réactions de fusion nucléaire

Le défi scientifique principal que la fusion doit relever est de créer dans un milieu matériel confiné les conditions nécessaires à ce que des noyaux atomiques légers, chargés positivement par nature, puissent vaincre leur répulsion coulombienne et se rapprocher suffisamment pour que les forces nucléaires entrent en jeu et les fassent fusionner. Ce type de réaction nucléaire est de très loin le plus répandu dans l’univers, puisque c’est lui qui préside à la production d’énergie des étoiles. La question devient donc : comment créer de « mini-étoiles » sur terre, les stabiliser et les placer au cœur de centrales de production d’électricité ?

2.1. Atteindre les conditions de la fusion

S’il est relativement facile d’utiliser un accélérateur de particules pour créer une collision de cette nature entre deux noyaux légers, il est considérablement plus compliqué d’entretenir de telles réactions « en volume » et sur des temps longs.

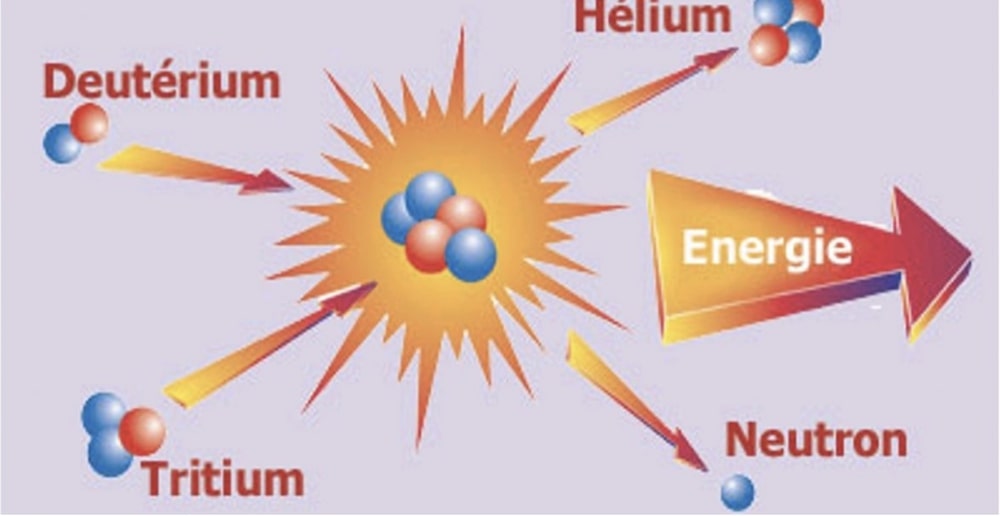

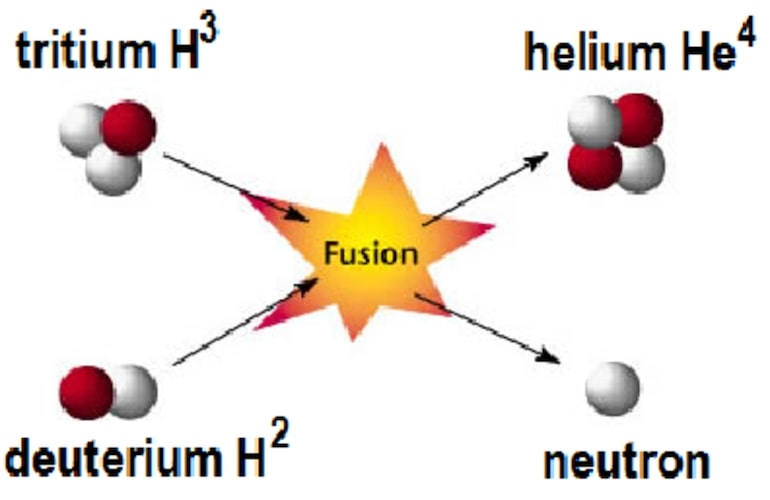

Tout commence par le choix des « réactifs », c’est-à-dire des noyaux qui vont fusionner. Si les étoiles sont capables de faire fusionner la majeure partie de leurs constituants, on doit d’abord sélectionner sur terre la réaction de fusion nucléaire la plus « facile », donc celle qui a la plus grande section efficace de réaction (figure 3). Celle-ci est la réaction qui fait fusionner un noyau de Deutérium (D, premier isotope de l’Hydrogène constitué d’un proton et d’un neutron) et un noyau de Tritium (T, second isotope de l’Hydrogène constitué d’un proton et de deux neutrons). Cette réaction demande ensuite de conférer à ces noyaux des vitesses relatives suffisantes leur permettant d’entrer en interaction nucléaire, donc de leur conférer une grande énergie.

Du point de vue thermodynamique, il s’agit donc de confiner ces noyaux D et T en quantité suffisante, sous une température suffisante, tout cela dans un milieu ayant des caractéristiques d’isolement thermique suffisantes pour laisser le temps aux réactions de se faire. Cet isolement thermique est donc habituellement mesuré par un temps, dit temps de confinement de l’énergie du milieu, qui reflète la capacité du milieu à conserver l’énergie générée par les réactions de fusion afin d’entretenir notamment la température du milieu et donc les réactions de fusion suivantes.

Le choix de la température est bien évidemment lié au choix de la réaction, et pour ce qui est de la réaction D-T, la section efficace est la meilleure pour des températures comprises entre quelques dizaines et une centaine de millions de degrés. Pour ce qui est des deux autres paramètres à satisfaire, densité et temps de confinement de l’énergie, ils vont dépendre du mode même de confinement du mélange D-T. Deux grandes voies de confinement existent. L’une mime l’effondrement gravitationnel qui permet aux étoiles de briller, c’est le confinement inertiel. Elle cherche à maximiser principalement le paramètre de densité. La seconde contraint les noyaux chargés électriquement à tourner indéfiniment autour de lignes fermées d’un champ magnétique, c’est le confinement magnétique. Elle favorise plutôt le paramètre temps de confinement.

2.2. Deux grandes voies de confinement

2.2.1. Le confinement inertiel

Le principe de la fusion par confinement inertiel consiste donc à comprimer un mélange initialement solide de deutérium et de tritium, de façon aussi rapide et adiabatique que possible. La montée en pression du milieu, s’accompagne ainsi d’une montée simultanée en densité et en température qui permet d’atteindre les conditions requises ci-dessus, du moins transitoirement. On mime ainsi en tout petit et via une implosion, ce qu’une étoile réalise naturellement par son effondrement gravitationnel stationnaire.

Ce principe, à l’œuvre dans les bombes H, est cependant complexe à mettre au point et surtout à maitriser pour plusieurs raisons.

La première de ces raisons est liée aux méthodes de compression d’une bille de mélange D-T. Les deux grandes techniques disponibles font appel à des faisceaux convergeant soit de particules, soit de lumière laser. Si, par exemple, l’énergie laser que l’on va chercher à faire converger sur la cible peut sembler raisonnable (quelques mégajoules), les temps de compression sont très faibles (quelques dizaines de nanosecondes). Les puissances à mobiliser sont donc colossales, de l’ordre de plusieurs centaines de térawatts (TW), et nécessitent des installations dédiées. Cela dit, de telles installations existent déjà au stade expérimental, telles le Laser Mégajoule du Centre d’études scientifiques et techniques d’Aquitaine du CEA (figure 4) ou la National Ignition Facility basée à Livermore aux États-Unis.

Figure 4. Le Laser Mégajoule du CEA en Aquitaine. [Source : © Lilian Maroolleau/CEA – https://www.20minutes.fr/bordeaux/1077915-20130111-vont-defiler-contre-megajoule#commentaires]

Le second défi de la voie inertielle réside ensuite dans l’obtention de la parfaite convergence de plusieurs centaines de faisceaux sur la cible, de façon à assurer la compression la plus isotrope du mélange, et éviter des instabilités qui amoindriraient les qualités de confinement de l’énergie, donc la performance de la réaction. Au-delà de la précision mécanique maintenant accessible entre des centaines de faisceaux convergents dans une enceinte de plusieurs mètres de diamètre sur une cible de quelques millimètres, les progrès ont longtemps été limités par la cible elle-même. En effet, une attaque « directe » de la cible par les faisceaux ne permet finalement pas d’assurer cette bonne isotropie de la compression. Une stratégie d’attaque dite indirecte a rapidement montré qu’elle était bien plus à même de satisfaire ces conditions d’isotropie. Pour ce faire, la cible de D-T est elle-même enfermée dans une cavité en or de forme particulière. Les faisceaux servent alors à « chauffer » cette cavité, qui se met à émettre des rayons X, eux-mêmes absorbés ensuite par la cible de D-T. C’est la géométrie de la cavité qui permet de contrôler l’isotropie. Les expériences citées plus haut atteignent désormais des conditions proches de la fusion de la cible, prouvant ainsi la faisabilité scientifique de cette voie.

Cela dit, la voie inertielle, si elle permet de réaliser des réactions de fusion lors de l’implosion d’une cible de D-T, ne permet pas encore d’envisager de pouvoir produire rapidement de l’énergie via ce procédé, du moins sur terre. En effet, pour être technologiquement, industriellement et commercialement viable, il faut encore imaginer comment collecter la puissance dégagée par l’implosion, comment répéter cette implosion plusieurs dizaines de fois par seconde afin de produire une énergie utilisable, et comment assurer un bilan énergétique favorable en comparant l’ensemble de l’énergie mobilisée à provoquer les implosions et l’énergie produite sous forme d’électricité. Le chemin à parcourir ici, et les moyens à mobiliser pour cela, restent considérables et ne permettent malheureusement pas encore de prédiction crédible à ce jour.

Il est à noter que la National Ignition Facility vient de rapporter tout récemment (août 2021) une avancée significative remarquable dans la démonstration de faisabilité scientifique de cette voie. En effet, une énergie de 1.3 MJ a été produite par une impulsion laser de 1.7MJ, sur une durée d’environ un dixième de microseconde. Ce record semble avoir été rendu possible non seulement par la fiabilité et la qualité de l’impulsion laser, mais également par une série d’optimisations de la cible (forme, positionnement…) rapprochant l’expérience de l’objectif visé.

2.2.2. Le confinement magnétique

Le principe de la fusion par confinement magnétique consiste quant à lui à confiner les noyaux du mélange D-T dans des champs magnétiques de géométrie et d’intensité telles que les particules chargées (noyaux et électrons) sont piégées sur des trajectoires en forme d’hélices spiralant à l’infini autour des lignes de champ. On fait alors croître, par des moyens externes, la température et la densité de ce milieu confiné jusqu’à satisfaire les conditions de fusion des noyaux recherchées.

L’extrapolation vers des milieux utilisables pour l’exploitation de telles réactions à des fins de production d’électricité semble aujourd’hui plus accessible.

Tout d’abord, on sait maintenant réaliser de telles « bouteilles magnétiques » de manière soit complètement stationnaire à l’aide d’aimants de géométrie adaptée, soit dynamique en combinant le champ magnétique stationnaire d’aimants à un champ magnétique créé par un fort courant électrique induit dans le mélange D-T lui-même. L’utilisation de matériaux supraconducteurs, actuellement à très basses températures, mais dans le futur très probablement à haute température, donne accès à des volumes fortement magnétisés de grande taille (plusieurs Teslas dans plusieurs dizaines, voire centaines, de mètres-cubes), sur des temps a priori infinis, et suffisants pour le but recherché.

Ensuite, on sait créer dans ces volumes les conditions de très basse pression assurant que les quelques grammes de mélange D-T utiles à la réaction garderont la pureté nécessaire.

Enfin, on maitrise désormais les technologies de chauffage d’un tel milieu, qui permettent de passer en quelques secondes d’un mélange D-T gazeux à un milieu totalement ionisé de plusieurs dizaines, voire centaines, de millions de degrés, fait d’électrons et de noyaux de D et de T. Ce quatrième état de la matière est désigné par le terme de « plasma ». Chacune de ces particules chargées est ainsi littéralement piégée dans le champ magnétique, les noyaux étant dans des conditions cinétiques telles que les collisions entre eux déclenchent une réaction de fusion.

L’histoire des recherches en fusion par confinement magnétique, des années 1960 à nos jours, témoigne de la formidable coopération scientifique mondiale à la hauteur de ce défi littéralement prométhéen : domestiquer l’énergie des étoiles.

3. Soixante ans de recherche et développement en fusion magnétique

A la fin des années 1950 en effet, la communauté internationale décide, sous l’impulsion de l’Agence Internationale de l’Énergie Atomique, de déclassifier une fraction importante des recherches en physique nucléaire. Dès la conférence « Atom For Peace » de 1958 à Genève, les chercheurs de nombreux pays commencent notamment à partager leurs idées quant à la possibilité de confiner des réactions de fusion nucléaire (figure 5). Les pionniers sont à cette époque les soviétiques, les américains et les anglais qui maîtrisent déjà la bombe à hydrogène. Une émulation naît très rapidement de ces premiers échanges, chacun reconnaissant que seule une coopération ambitieuse et d’excellence sera à la hauteur du défi.

Figure 5. Atom for Peace. [Source : Bureau of Engraving and Printing, Public domain, via Wikimedia Commons]

3.1. Les pionniers

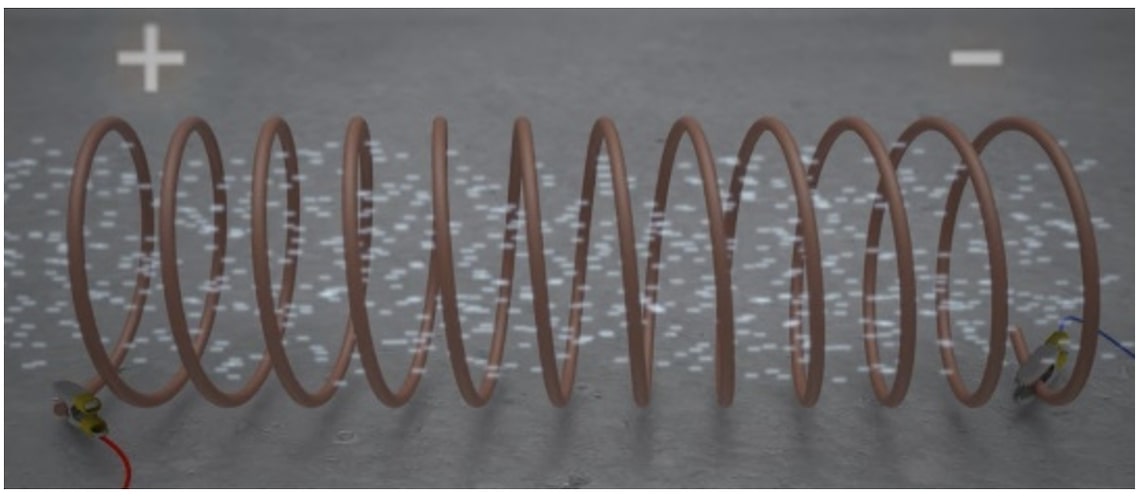

L’effort s’est tout d’abord concentré pendant une vingtaine d’années sur la configuration magnétique elle-même, dans le but de trouver la meilleure bouteille magnétique pour des noyaux de D et T. Un simple ensemble de lignes de champ magnétique toutes parallèles entre elles, créées par des bobines de courant toutes rangées parallèlement les unes aux autres et perpendiculairement au champ magnétique induit, est déjà une excellente base (figure 6). En effet, les particules chargées, noyaux ou électrons, développent des trajectoires hélicoïdales s’enroulant autour de ces lignes de champ. Plus le champ magnétique est intense, plus le rayon de l’hélice est petit.

En revanche, le pas de l’hélice, lui, ne dépend pas de l’intensité du champ magnétique. Une telle configuration, si elle confine bien les particules dans la direction transverse aux lignes de champ, les laisse donc s’échapper à chaque extrémité du cylindre, et présente de ce fait un très faible temps de confinement. En augmentant l’intensité du champ aux extrémités de ce cylindre, on provoque un échange entre les mouvements perpendiculaire et parallèle, et on améliore le confinement en forçant les particules les moins rapides à rebrousser chemin lorsqu’elles approchent des extrémités du cylindre. Mais cela de façon trop imparfaite malheureusement pour l’objectif de confinement visé.

Il faut donc plutôt « supprimer » les extrémités du cylindre en refermant celui-ci sur lui-même, donnant naissance à une géométrie torique, qui piège naturellement les particules le long des lignes de champs (figure 7). Le temps de confinement observé s’améliore certes grandement, mais, à nouveau, pas suffisamment. En effet, ce repliement en anneau du cylindre sur lui-même modifie l’uniformité spatiale du champ magnétique (celui-ci est plus intense sur le côté intérieur que sur le côté extérieur du tore), ce qui a pour effet de créer une dérive, cette fois-ci verticale, des particules et donc une perte de confinement.

Pour compenser cette perte de confinement, il faut enrouler à nouveau les lignes de champ, mais cette fois-ci en hélice autour de l’axe annulaire du tore (figure 8). La dérive verticale des particules est toujours présente, mais elle se trouve moyennée à zéro du fait que les lignes de champ occupent désormais autant la partie basse que la partie haute du tore.

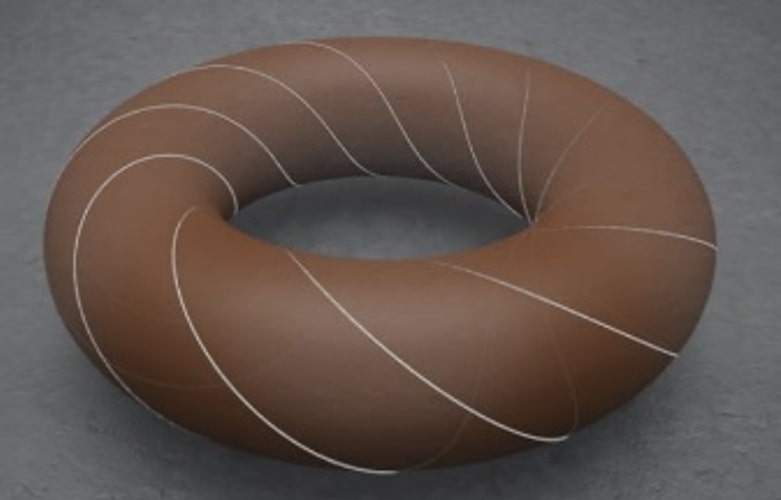

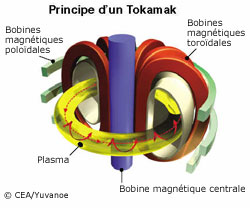

Il existe deux façons de réaliser techniquement une telle configuration. Soit le volume torique est entouré de bobines planes placées verticalement et réparties régulièrement. Cet arrangement crée la composante torique (on dit toroïdale) du champ. Un fort courant toroïdal est ensuite induit dans le milieu générant à son tour un champ magnétique (dit poloïdal) dans le plan vertical. La résultante de ces deux champs est la configuration hélicoïdale désirée (figure 9). Cette solution, mise au point par les chercheurs russes dans les années 1960, a été baptisée tokamak, acronyme de l’expression russe «тороидальнаякамера с магнитнымикатушками» (phonétiquement « toroïdalnaïakamera s magnitnymikatushkami », ou en français « chambre toroïdale avec des bobines magnétiques »).

Figure 9. Tokamak. [Source : © CEA ; https://www.cea.fr/comprendre/Pages/energies/nucleaire/fusion-nucleaire.aspx?Type=Chapitre&numero=3]

L’autre façon de réaliser une configuration magnétique hélicoïdale est de forger des bobines de champ magnétique la réalisant directement. Ce problème de résolution inverse des équations de la magnétostatique a donné lieu à plusieurs essais de ce qui est devenu petit à petit le stellarator, désormais cousin du tokamak. Bien que moins répandu, car beaucoup plus complexe à construire notamment, le stellarator présente l’avantage important de la stationnarité de sa configuration magnétique, qui lui ouvre des perspectives intéressantes pour les étapes futures vers le réacteur.

Bien d’autres configurations magnétiques ont été imaginées dans cette phase pionnière de la recherche, mais de loin le tokamak est celle qui a donné jusqu’ici les meilleurs résultats.

Tout d’abord, le courant intense qui est nécessaire pour créer le champ magnétique poloïdal du tokamak est également la composante première et majeure du chauffage du milieu par effet Joule : l’état de la matière totalement ionisée, faite d’électrons et d’ions D et T, est appelé plasma. C’est un milieu résistif qui s’échauffe donc au passage d’un tel courant.

La résistivité du plasma n’est cependant pas suffisante, et de plus elle décroit avec la température du milieu. Le seul chauffage par effet Joule ne suffit donc pas à monter la température du milieu dans la gamme recherchée de quelques centaines de millions de degrés. On fait alors appel à des systèmes de chauffages dit additionnels.

Ceux-ci sont basés sur deux grands mécanismes fondamentaux de la physique.

Le premier consiste à accélérer de manière électrostatique, à la périphérie du milieu, des ions D-T jusqu’à des vitesses (donc des températures) supérieures à celles de ions du plasma, puis à les injecter afin qu’ils échauffent le milieu cible par collisions. Si l’idée est très simple et intuitive, sa réalisation est complexe. Il faut en pratique savoir créer des faisceaux d’ions de plusieurs dizaines d’ampères sous des tensions de l’ordre du million de volt. L’injection dans le plasma requiert ensuite de neutraliser le faisceau accéléré, car, si la bouteille magnétique empêche les ions du plasma de sortir, elle empêche également toute injection de particules chargées depuis l’extérieur. A ces énergies la neutralisation de noyaux positifs de D ou de T, réalisée par traversée d’un nuage de gaz neutre, est excessivement inefficace. Le processus n’est en pratique utilisable dans les grands tokamaks qu’en créant à basse énergie, puis en accélérant, des ions négatifs (D– ou T–), puis en les neutralisant par arrachement de l’électron supplémentaire par traversée d’un nuage de gaz neutre.

Le second principe de chauffage d’un plasma de fusion repose sur l’interaction résonante d’une espèce de particules du plasma, noyau ou électron, avec une onde électromagnétique injectée depuis la périphérie du tokamak via des antennes. Le mouvement des particules chargées piégées dans le champ magnétique étant multi-périodique (mouvement cyclotronique autour des lignes de champ magnétique, et mouvement de dérive des particules le long des lignes hélicoïdales de champ), il existe plusieurs voies de chauffages, à plusieurs fréquences. Les gammes vont de quelques dizaines de mégahertz pour des ondes se couplant au mouvement cyclotronique des ions, à quelques centaines de gigahertz pour des ondes se couplant au mouvement cyclotronique des électrons, en passant par quelques gigahertz si l’on cherche à accélérer les électrons dans leur mouvement le long du tore, c’est-à-dire si l’on cherche à soutenir le courant plasma de manière non inductive.

3.2. Les lois d’échelles

Une fois la configuration magnétique la plus prometteuse sélectionnée par les scientifiques, la seconde grande phase de la recherche et du développement de l’énergie de fusion par confinement magnétique a couvert essentiellement les deux dernières décennies du 20ème siècle. Elle a été consacrée d’une part aux études paramétriques des performances de cette configuration tokamak. Plus précisément il s’est agi de caractériser la qualité du confinement en fonction des paramètres que l’on peut imposer de l’extérieur, à savoir la géométrie (volume, forme et surface de la section poloïdale), l’intensité du champ magnétique, du courant plasma, la densité ou la composition du milieu. Il a fallu en particulier construire plusieurs tokamaks différents et en partager les résultats au niveau mondial. On a non seulement retiré de cette période les lois d’échelles qui régissent le confinement, mais également compris la majeure partie des mécanismes physiques sous-jacents, avec quelques bonnes ou mauvaises surprises. Si la taille du milieu et l’intensité du champ magnétique sont fondamentales pour obtenir les conditions nécessaires aux réactions (« size matters »), les performances en sont régies, voire saturées, par des mécanismes complexes de turbulence électromagnétique. Cette « magnétohydrodynamique » du milieu peut également déclencher des instabilités plus macroscopiques, voire conduire dans les tokamaks à la disparition soudaine de la configuration magnétique et donc du plasma: on parle alors de disruption. Une science du contrôle en temps réel d’un plasma de fusion s’est donc mise en place, afin de pouvoir allumer, mais également maintenir un tel plasma en équilibre.

Le côté positif de cette magnétohydrodynamique est qu’un plasma de tokamak ne peut jamais s’emballer. Bien au contraire, tout paramètre non suffisamment piloté conduit à l’extinction pur et simple de la réaction. Un réacteur exploitant la fusion dans un tel milieu sera donc intrinsèquement sûr, sans aucune possibilité d’emballement ou de divergence.

Cette seconde grande période de la recherche en fusion a également permis en parallèle de développer et de valider la majeure partie des technologies nécessaires au déclenchement et au maintien des réactions de fusion dans un tokamak. Outre les aimants supraconducteurs déjà évoqués ci-dessus, sans lesquels la configuration magnétique elle-même ne pourrait être maintenue sur des temps très longs, la communauté fusion mondiale a su mettre au point les techniques d’injection d’atomes neutres à très haute intensité ou les systèmes multi-mégawatts de chauffages par ondes, tout cela également de manière continue.

Dans le même ordre d’idées, un très grand défi technologique à relever était, et reste encore en partie, la gestion en continu de la chaleur générée par le cœur du plasma en fusion, et notamment son évacuation à la périphérie de celui-ci. Rappelons que cette chaleur, une fois récupérée au sein des futurs réacteurs, servira à la génération de vapeur et donc à la production d’électricité. Il est crucial de savoir la gérer parfaitement. Un chiffre symbolise ce défi majeur, celui de la densité de puissance atteignant la zone principale de collecte de cette chaleur, un composant baptisé divertor. Ce composant solide doit en effet collecter en continu entre 10 et 20 millions de watts (MW) au mètre-carré, c’est-à-dire, à un facteur 2 ou 3 près, être aussi performant que celui dont on aurait besoin si l’on voulait un jour positionner et maintenir une sonde sur la surface du soleil, sans la détruire.

Plusieurs décennies ont été nécessaires à la mise au point d’un tel composant alliant à la fois un qualité réfractaire exceptionnelle, une excellente conduction de la chaleur afin que celle-ci soit évacuée de la surface du composant vers des canaux de refroidissement internes, et de résistance en surface à l’érosion physico-chimique du plasma qui vient en contact. L’optimisation comprend également la géométrie fine de ce composant, mettant à profit la géométrie précise des lignes de champ magnétique dans la région périphérique du plasma. Ce type de divertor équipe désormais les tokamaks et les stellarators « modernes », qui ont la charge de le valider pleinement.

Enfin, les équipes de recherche du monde entier ont également mis au point et validé de très nombreux instruments de mesure, appelés diagnostics, qui permettent aujourd’hui de reconstruire et de suivre toutes les caractéristiques importantes du plasma (température, densité, courant, rotation, entre autres) en temps réel et en 2D, voire 3D. Ces diagnostics et les progrès de l’informatique permettent désormais de littéralement piloter en temps réel les paramètres extérieurs d’un tokamak (forme, courant, densité, chauffages additionnels, notamment), et, par-là, de le garder dans sa zone de performance et de stabilité.

3.3. La faisabilité intégrée

Tout était donc prêt à la fin du 20ème siècle pour envisager de réunir l’ensemble des connaissances scientifiques et l’ensemble des technologies en une seule expérience, première preuve complète et à l’échelle des futurs réacteurs, de la faisabilité scientifique et technologique de la maitrise des réactions de fusion sur terre.

4. ITER, le chemin

4.1. Un projet mondial pour relever un défi planétaire

Ce projet, baptisé ITER, « le chemin » en latin, a tout d’abord été un défi scientifique et technique dans sa phase conceptuelle initiale. En effet, les lois d’échelles du confinement, combinées aux limites à la fois du champ magnétique maximum et des efforts qu’un câble supraconducteur à basse température peut supporter, mais aussi les limites intrinsèques des technologies du divertor, ont dimensionné ITER à un volume de plasma d’environ 1000 m3, un champ magnétique moyen de plus de cinq teslas et un courant plasma pouvant atteindre quinze, voire dix-sept, millions d’ampères.

A cette taille, ITER est attendu générer une puissance fusion allant jusqu’à 500 mégawatts (MW), amplifiant ainsi jusqu’à 10 fois la puissance de chauffage additionnel dont il sera doté, et ce sur des durées de plasma dépassant les 400 secondes. Ce colosse doit donc embarquer tous les processus et les technologies à même de générer et maintenir des plasmas de D et de T en combustion. Il a également pour mission de gérer sa construction et sa maintenance nucléaire de manière complète, de sa construction à son démantèlement, c’est-à-dire de devenir la toute première installation nucléaire de base de la fusion, et en définir ainsi les standards.

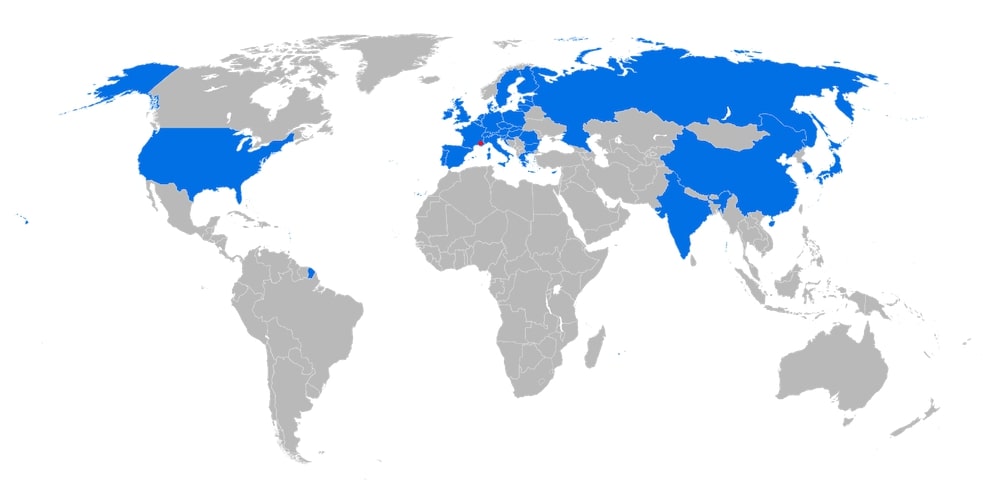

Le dessin conceptuel d’ITER, entrepris dès les années 1990 de manière internationale, a été l’objet de nombreuses discussions et versions, jusqu’au début des années 2000, où le projet fut jugé suffisamment mûr conceptuellement parlant pour que s’engagent des pourparlers entre les partenaires sur son financement et sa localisation. Plusieurs livres seraient nécessaires pour relater cette période riche en diplomatie et en rebondissements, mais la véritable leçon à retenir ici c’est l’engouement d’un ensemble de pays représentant à ce jour plus de la moitié de la population mondiale, et 80 % de son PIB, soit Chine, Corée du sud, Inde, Japon, Russie, Union Européenne, États-Unis (figure 10), pour une coopération scientifique totalement ouverte et pacifique à la mise au point d’une nouvelle source d’énergie, quasi-inépuisable, respectueuse de l’environnement et intrinsèquement sure. La crise environnementale qui s’est précisée en parallèle n’a fait qu’en renforcer l’intérêt, voire l’urgence.

Si l’échelle de temps du développement de la fusion dépasse celles de la géopolitique, la confiance des partenaires en la faisabilité du projet ITER, et en son intérêt pour l’humanité n’ont jamais été remis en cause depuis la signature du traité international le 21 novembre 2006 au palais de l’Elysée, à Paris, et la création de l’Organisation Internationale qui coordonne cet effort international sans précédent. Le site de construction a été fixé par les partenaires à Cadarache, sur la commune de Saint-Paul-les-Durance, au cœur de la Provence (figure 11).

C’est donc depuis fin 2006 qu’ITER s’y construit. L’assemblage du tokamak, à proprement parlé, a débuté au mois d’août 2020, et les premiers plasmas sont attendus vers la fin de 2025.

4.2. Paver le chemin vers une nouvelle filière réacteur

ITER est une cathédrale de technologies. Le tokamak une fois assemblé pèsera 23 000 tonnes. La cage magnétique entièrement supraconductrice, refroidie à l’hélium liquide à -269 degrés Celsius, et chargée de confiner le plasma, pèse à elle-seule 10 000 tonnes et est formée de 18 bobines toroïdales de 17 mètres de haut et de 360 tonnes chacune, de 6 bobines poloïdales dont les plus grandes font 24 mètres de diamètre et d’un solénoïde central de 18 mètres de haut. La double enceinte à vide torique en acier renferme 800 mètres-cube d’un plasma parcouru par un courant pouvant atteindre 17 millions d’ampères. Les systèmes de chauffage additionnels du plasma peuvent injecter jusqu’à 73 millions de watts en continu pour la phase initiale, et jusqu’à 110 millions de watts dans les phases ultimes du projet, si nécessaire. Les composants face au plasma sont une combinaison d’un « mur lointain » refroidi et recouvert de béryllium, et d’un divertor en tungstène massif également entièrement refroidi, capable de gérer en continu les flux de chaleur et de particules au bord du plasma.

ITER est ainsi chargé d’une démonstration en vraie grandeur de la domestication des réactions de fusion sur Terre. Il est censé produire entre 400 et 500 mégawatts (MW) de fusion, sur des durées allant de 400s à une heure. La puissance est tout à fait comparable à celle d’un réacteur nucléaire de fission. Pour cela, et en tant qu’installation expérimentale, ITER sera alimenté de l’extérieur en tritium pour son fonctionnement quotidien, mais les partenaires fourniront également quatre éléments de couverture dites «tritigène», de technologies différentes, qui préfigureront la future production auto-suffisante du tritium in-situ dans les réacteurs de fusion.

Le planning actuel d’ITER est le suivant.

Alors que depuis plusieurs années les partenaires d’ITER s’affairent à fabriquer dans leurs usines le million de composants de ce gigantesque puzzle, la phase de construction des bâtiments et services est désormais bien avancée et se poursuit en parallèle de l’assemblage du tokamak lui-même. Ainsi, alors que la base et le cylindre inférieur du cryostat sont installés dans le « pit » depuis 2020, le premier des neufs secteurs composant l’enceinte à vide est désormais prêt à recevoir deux bobines toroïdales de champ magnétique, avant d’être le premier à rejoindre sa place finale dans le cryostat. Cette opération se répètera neuf fois au cours des mois et années à venir. En parallèle, les deux bobines poloïdales inférieures sont en place et le premier module du solénoïde central se présente déjà sur le site. Les principaux services sont en fin de construction, voire pour certain en phase de mise en service : alimentation électrique complète du site, usine cryogénique, usine de refroidissement, pompages, notamment. Cette phase dite de premier assemblage fera place à une première mise en service du tokamak et un premier plasma après 2025. Elle sera suivie d’une succession de phases d’assemblage complémentaire et d’expérimentation pour aboutir en 2035 au point de fonctionnement nominal de l’installation et à son exploitation pendant une dizaine d’années.

L’exploitation scientifique d’ITER doit donc s’étaler sur une vingtaine d’années en tout, et fournir la preuve de la maîtrise scientifique et technique des réactions de fusion à l’échelle d’un futur réacteur, ouvrant ainsi la porte à une industrialisation du procédé.

Comme toute installation nucléaire sur le sol national, ITER est bien évidemment soumis au respect des règles de dessin, construction et exploitation de l’Autorité de Sureté Nucléaire (ASN). A ce titre, une coopération internationale a été mise sur pieds afin d’élaborer le dossier de sureté d’une telle installation, encore unique en son genre. Celle-ci englobe bien évidemment tous les aspects de maintenance et de déconstruction en fin de vie. Il faut rappeler, et répéter, que si les réactions de fusion du deutérium et du tritium ne produisent aucun élément radioactif, le tritium lui-même est radioactif, et les neutrons générés par la réaction vont activer les matériaux qu’ils rencontrent sur leur chemin. Cela fait donc du tokamak lui-même, à la fin de sa vie, un « déchet nucléaire ».

Une grande partie de la mission d’ITER est donc également de prouver que le cycle de gestion du tritium est maîtrisable, et qu’un tel tokamak peut être construit à partir de matériaux dont les taux d’activation sous irradiation neutronique permettent une déconstruction « simple et rapide » en fin de vie, en réduisant au maximum tout déchet à vie moyenne ou longue. Si l’Organisation Internationale ITER est chargée de définir et d’opérer tous les systèmes, robotisés, et les procédés de maintenance en cellule chaude pendant toute la vie de l’installation, c’est le pays-hôte d’ITER, la France, qui se chargera de piloter les opérations de déconstruction, et le « retour au vert ». Il est évident que l’attractivité ultime de cette nouvelle source d’énergie passera par le succès de cette démonstration.

ITER, une fois assemblé, ne sera un succès que s’il sait mobiliser l’ensemble des compétences scientifiques de ses partenaires au sein d’une coopération scientifique de toute première excellence. Pour cela, la communauté scientifique de la fusion continue en parallèle de la construction d’ITER à utiliser ses tokamaks existants qui, même s’ils sont de taille beaucoup plus modestes, apportent en continu des éléments précieux à la future la montée en puissance d’ITER. En parallèle, de très nombreux développements théoriques et numériques sont poursuivis. La physique des plasmas chauds et magnétisés de fusion reste un des domaines les plus complexes de la science moderne, avec de nombreuses découvertes encore à venir et un espace quasi-illimité pour les simulations numériques sur les superordinateurs de très haute performance existants ou à venir. En cela, ITER est également une aventure aux limites de la connaissance humaine, naturellement génératrice d’innovations.

5. Et après ?

Il est très clair qu’ITER est désormais sur le chemin critique de tout développement crédible futur de l’énergie de fusion par confinement magnétique.

Pour autant, il ne mobilise pas l’intégralité des fonds ni des activités actuelles sur le sujet. Tout d’abord, et pour la recherche publique des sept partenaires d’ITER, il représente une étape de faisabilité indispensable et à ce titre il focalise leurs programmes nationaux ou supranationaux, tant au niveau de la modélisation scientifique, que des expérimentations dites d’accompagnement ou encore des développements technologiques. ITER est également le laboratoire d’essai qui permettra de valider les étapes suivantes d’industrialisation du procédé. Ainsi, par exemple, l’Europe est-elle structurée sous la bannière EURATOM via le Consortium EUROfusion regroupant l’ensemble des pays membres plus la Suisse et le Royaume-Uni, fédérant ainsi ses efforts autour i) de sa préparation à participer aux expériences ITER et ii) de sa R&D et du dimensionnement de son premier réacteur de démonstration baptisé DEMO. EUROfusion est donc un vaste programme incitant chacun de ses membres à suivre la feuille de route européenne vers l’énergie de fusion. Cette feuille de route prévoit que DEMO commencera, fut-ce symboliquement, à coupler de l’électricité au réseau européen dans le milieu des années 2050. Des programmes similaires existent, plus ou moins développés, chez la majeure partie des partenaires ITER. La question politique de la coopération pour cette étape DEMO n’est pas encore abordée de manière ferme par ces pays.

Dans la plupart des cas, DEMO représente une « traduction » par l’industrie de la preuve de faisabilité ITER. DEMO inclut a priori l’autosuffisance de sa production de tritium in-situ (chaque neutron produit par les réactions de fusion au cœur du plasma génère au moins un noyau de tritium au niveau de la paroi de l’enceinte à vide alors qu’il y interagit avec une couverture enrichie en lithium). Il embarque également tout la fonctionnalité de génération de vapeur, et donc d’électricité, à partir de la chaleur collectée. Son fonctionnement doit alors être le plus continu possible, et sa disponibilité la plus proche de celle d’un réacteur commercial.

L’étape de commercialisation (parfois baptisée PROTO) suit naturellement DEMO, avec des contraintes d’efficacité globale sur l’ensemble du processus du « plasma à la prise », et bien entendu une optimisation des coûts de fabrication et d’exploitation amenant ce type de réacteur à la compétitivité indispensable (au sens large) face aux autres sources d’électricité. C’est à ce stade notamment qu’un stellarator pourrait devenir plus attractif qu’un tokamak, puisqu’il ne nécessite plus la part de puissance recirculante liée à la génération du courant plasma notamment.

Ce type de feuille de route soulève néanmoins un problème de taille si l’on veut connecter la production d’énergie par la fusion à la problématique actuelle du réchauffement climatique et de la transition énergétique.

Comment accélérer la démonstration de faisabilité et d’attractivité de l’énergie de fusion à ce stade du développement ? Le calendrier d’ITER est celui de la recherche publique de la moitié de la population mondiale. On a du mal à imaginer pouvoir brûler les étapes si facilement, et réduire significativement le fameux « time to market » de cette solution.

C’est pourtant le défi que plusieurs investisseurs du secteur privé tentent de relever depuis environ une dizaine d’année, en envisageant des développements plus agiles, audacieux voire risqués au sens de l’investissement de capital.

La décision par les partenaires de construire ITER en 2006, combiné à l’extrême importance de la question de l’énergie au niveau mondial, a en effet amené ces investisseurs à importer les méthodes actuelles d’exploration et de développement des marchés sur le terrain de la fusion. On a vu ainsi se créer un grand nombre de startups de la fusion, principalement sur les marchés anglo-saxons traditionnellement dynamiques en la matière. Si l’on peut déplorer des débuts de communication sur le thème de la recherche publique incapable de réaliser un tel réacteur pour cause soit d’incompétence soit de manque de flexibilité, le positionnement de ces startups a assez rapidement évolué vers une complémentarité avec la recherche publique, ouvrant très certainement de nouvelles perspectives communes, sinon une synergie potentielle à terme.

La première complémentarité se rencontre en matière de modes de confinement magnétique. Un très grand nombre des configurations magnétiques envisagées dans les premières décennies de la fusion ont été abandonnées à la faveur du tokamak, mais peut-être parfois trop rapidement et certaines d’entre-elles méritent d’être revisitées. Cela permet à ces entreprises de proposer des machines de fusion un peu différentes des tokamaks actuels et parfois de compléter les informations sur les lois d’échelles par exemple, tout en se lançant souvent dans de vrais défis technologiques.

C’est là, la seconde complémentarité, pour ne pas dire vertu, de ces initiatives. Étant en général de petite structures employant des spécialistes traditionnels de la fusion et de jeunes chercheurs et ingénieurs venant d’horizons très divers, elles ont une vraie capacité à proposer des ruptures technologiques dans un certain nombre de grands défis de la fusion : la supraconductivité à haute température pour les aimants des tokamaks ou des stellators, les matériaux liquides pour des divertors plus performants, des méthodologies nouvelles en matière de couverture tritigène, des méthodes nouvelles de diagnostics, entre autres. En cela, elles ouvrent des voies nouvelles de R&D que les laboratoires pleinement mobilisés à construire ITER ne peuvent qu’effleurer. Cependant, ces start-ups doivent aussi jouer avec les propres règles de leurs investisseurs, et si elles ont certes comme point focal l’énergie de fusion, elles ont aussi besoin de jalonner cette recherche de très longue haleine par des retombées et des activités valorisant leurs résultats à plus court terme, c’est une difficulté !

La troisième complémentarité de ces initiatives se révèle avec le temps. Celles qui arrivent à passer à un stade supérieur de développement, rencontrent en effet un créneau très important à considérer : celui de l’industrie de la fusion. En effet, la recherche publique actuelle, ITER compris, fait grand usage des industries de pointe sur toute la planète, mais aucune d’entre elle ne considère encore à ce stade la fusion comme un « marché ». On est encore loin d’avoir des industries du divertor ou du chauffage cyclotronique des tokamaks. Ces investissements privés, à nouveau principalement du monde des affaires anglo-saxon, peuvent être vus comme l’embryon d’une telle industrie et, par-là, témoignent aussi du degré de maturité et de crédibilité que les recherches en fusion atteignent avec ITER. L’implication de la force publique et de la recherche associée semble cependant un ingrédient indispensable et sécurisant dans un domaine qui met en jeu des aspects de sûreté nucléaire, fussent-ils a priori plus simples que ceux de la fission.

Pour conclure

La transition énergétique dont notre planète a désormais un besoin urgent ne pourra se réaliser qu’à la condition d’une réelle prise de conscience de l’ampleur collective, et non compétitive, du problème, et qu’avec une détermination des responsables politiques et des industriels, cohérente et sans faille sur plusieurs générations humaines. Il nous faut tous intégrer la responsabilité collective et les constantes de temps du problème. Il n’y aura pas de solution simple et rapide au déséquilibre engendré par une consommation toujours grandissante d’énergie.

La science et la technologie seront les seules à pouvoir relever réellement, durablement et pacifiquement un tel défi. La fusion des noyaux légers ne pourra cependant pas aider dans l’immédiat à résoudre le profond déséquilibre que l’Homme a créé sur sa planète. Mais elle a un très net potentiel dans le futur durable des nouveaux mix énergétiques et se doit donc d’être explorée pleinement. Seule des coopérations à l’échelle planétaires pourront faire face aux enjeux climatiques. En cela, le projet ITER a déjà pleinement réussi sa mission : celle de mettre les meilleurs scientifiques et ingénieurs autour d’un des projets les plus ambitieux à ce jour.

Pour des informations complémentaires, vous pourrez trouver ci-dessous, l’intervention de Bernard Bigot, Administrateur Général d’ITER, lors de la conférence de l’Institut Schiller des 5 et 6 Septembre 2020.

Quatre vidéos de l’auteur, sur le sujet :

- https://www.franceinter.fr/emissions/les-savanturiers/les-savanturiers-26-janvier-2019

- https://www.franceculture.fr/emissions/la-methode-scientifique/voyage-au-centre-diter

Et enfin, un livre de l’auteur :

L’actualisation ci-dessous vient de Paul Molga. Iter : cinq ans de retard en vue pour le chantier du réacteur à fusion nucléaire. Les Echos, 25.11.2022.

L’Autorité de Sûreté Nucléaire (ASN) confirme les défauts de soudure qui vont retarder la réalisation du projet ITER (Cadarache) et avec lui

le surcoût d’1 G€ sur un total d’une vingtaine.

Selon Michel Claessens, ancien porte parole d’Iter aujourd’hui à la retraite, « l’étanchéité du réacteur est compromise » en raison de

défauts de structure sur les murs et les fondations mêmes des trois bâtiments nucléaires. « La protection contre les rayonnements pourrait

être réduite d’un tiers », affirme-t-il. Or il n’est pas certain que la dalle, conçue pour soutenir une charge de 400.000 tonnes, puisse

supporter une charge d’étanchéité supplémentaire sans se briser.

Le chiffrage de l’ensemble de ces réparations sera présenté aux nations membres d’Iter (Union européenne, Chine, Inde, Japon, Corée,

Russie, Etats-Unis) lors du prochain Conseil prévu en juin 2023, alors que réunies début novembre 2022, elles ont unanimement renouvelé

leur engagement.

Notes et références

[1] La communauté mondiale de recherche en fusion, bien que très connectée, reste être encore une communauté modeste comptant à ce jour de l’ordre d’une à deux dizaines de milliers de chercheurs, ingénieurs et techniciens.