L’explosion du numérique permet-elle d’économiser de l’énergie ou fait-elle appel à toujours plus d’électricité ? Dans cette ère de digitalisation accrue de la société, il est donc indispensable de se pencher sur l’efficacité énergétique du numérique. C’est ce qu’a fait l’entreprise grenobloise Stimergy à travers son innovation : la création d’une chaudière numérique.

Alors qu’il est difficile de parler de sobriété numérique, dans cette ère de digitalisation accrue de la société, il est intéressant de se pencher sur l’efficacité énergétique du numérique. L’entreprise grenobloise Stimergy a réussi à mêler ces deux problématiques d’actualité à travers son innovation : la création d’une chaudière numérique. Christophe Perron, le créateur de cette jeune start-up a en effet eu l’idée de récupérer la chaleur émise par les serveurs informatiques afin de préchauffer l’eau sanitaire des immeubles d’habitations ou des bâtiments publics (piscines et universités par exemple). La présentation de cette innovation dans l’air du temps suivra l’évocation du contexte dont elle est issue.

1. Les systèmes d’information : réalité physique et modes de fonctionnement

Nous vivons désormais dans l’ère du numérique : les informations, codées sous forme de nombres, constituent des quantités phénoménales de données échangées en permanence à travers le monde tant par les particuliers que les entreprises et collectivités. En 2016, on compte ainsi 3,77 milliards d’internautes, soit la moitié de la population mondiale, 50 % du trafic étant réalisé via les téléphones mobiles[1]. Quelques 100 millions de sites internet actifs sont consultés, sur les 920 millions recensés sur la toile, et 144 milliards de messages sont échangés chaque jour[2].

Pour les entreprises, on peut dire avec le syndicat professionnel du numérique français que « le système d’information représente leur nouveau système nerveux. Il véhicule les flux de données entre applications, collaborateurs et partenaires. Sans lui, une entreprise est paralysée et ne peut plus fonctionner »[3]. Il en va de même pour toutes les organisations.

Comme le système nerveux, le système d’information a besoin de supports physiques pour fonctionner. En voici les principaux éléments constitutifs et les modes de fonctionnement associés.

1.1. Les serveurs au cœur des réseaux informatiques

Les ordinateurs, machines à traiter électroniquement les données[4], ont d’abord fonctionné selon un modèle centralisé (mainframe): l’environnement informatique était composé d’un système central relié à un ensemble de terminaux, un peu comme une centrale nucléaire alimente les consommateurs d’électricité. Les ordinateurs centraux puissants ou « macro-ordinateurs »[5]sont encore utilisés dans les très grandes entreprises mais, avec le développement des micro-ordinateurs, est apparu le besoin de pouvoir échanger des informations entre les machines des différents utilisateurs.

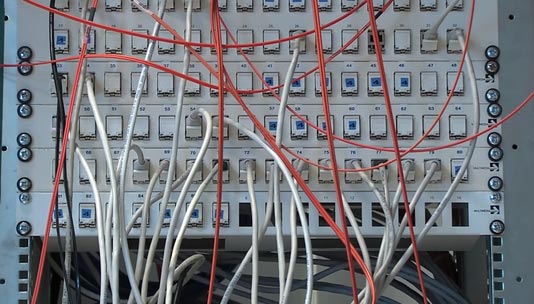

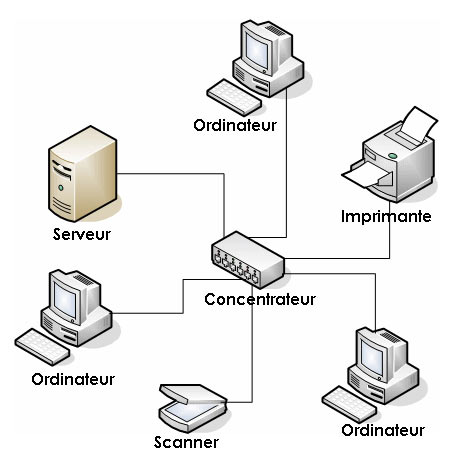

Ainsi ont été développés les réseaux informatiques, ensembles d’équipements reliés entre eux pour échanger des informations sous forme numérique. Les liens entre les équipements se font par signaux électriques circulant dans des câbles, des ondes radios, ou des ondes lumineuses se propageant dans des fibres optiques. Ces liens nécessitent l’ajout de matériels intermédiaires (routeur, pare-feu, répartiteur, concentrateur, commutateur) et sont régis par des ensembles de règles ou protocoles (Figure 1).

Il existe maintenant de multiples réseaux : réseau personnel, réseau local (à l’intérieur d’un bâtiment), réseau métropolitain, réseau étendu (à un pays, un continent ou l’ensemble du monde), dont le plus grand, internet, est le réseau mondial accessible au public (en fait réseau de réseaux interconnectés par le protocole IP).

Au cœur du réseau se trouve le serveur, composé d’un ou plusieurs ordinateurs qui administrent le réseau : « le serveur gère l’accès aux ressources et aux périphériques et les connections des différents utilisateurs. Il est équipé d’un logiciel de gestion de réseau »[6].

Les serveurs fonctionnent en permanence, pour répondre automatiquement aux requêtes des clients qui peuvent être simultanées. Des ordinateurs de toutes tailles, ayant la puissance de calcul nécessaire, peuvent remplir le rôle de serveurs. On en distingue trois grandes catégories[7].

- Les « serveurs traditionnels » (stand-alone) sont dotés d’un seul système d’exploitation ; ils hébergent une à deux applications (ou programme ou logiciel) par machine et sont reliés en propre à l’électricité et au réseau informatique (Figure 2). Ils ne sont exploités qu’à 10 à 20 % de leur capacité. Ce sont les plus répandus.

- Les « serveurs lame » (blade), ayant un très faible encombrement (Figure 3), sont regroupés dans des armoires de raccordement aux dimensions standardisées appelées « baies » (rack) qui mutualisent leurs contacts physiques (réseaux et électricité) avec l’extérieur (Figure 4).

- Les « serveurs virtualisés » sont des copies logicielles de serveurs physiques stand-alone. Installer plusieurs serveurs virtualisés qui ne fonctionnent pas au même moment sur une même machine permet une mutualisation des moyens et optimisela charge de fonctionnement de la machine. C’est ce qu’on appelle la virtualisation.

La relation entre l’utilisateur et le serveur fonctionne selon un mode de communication appelé client-serveur de la façon suivante : « un programme client, généralement doté d’une interface conviviale, est installé sur l’ordinateur de l’utilisateur. Quand l’utilisateur lance une commande, le programme client en lance une autre, plus complexe, sur le serveur indiqué. Celui-ci exécute la requête et retourne l’information demandée au programme client qui l’affiche sous une forme exploitable »[8].

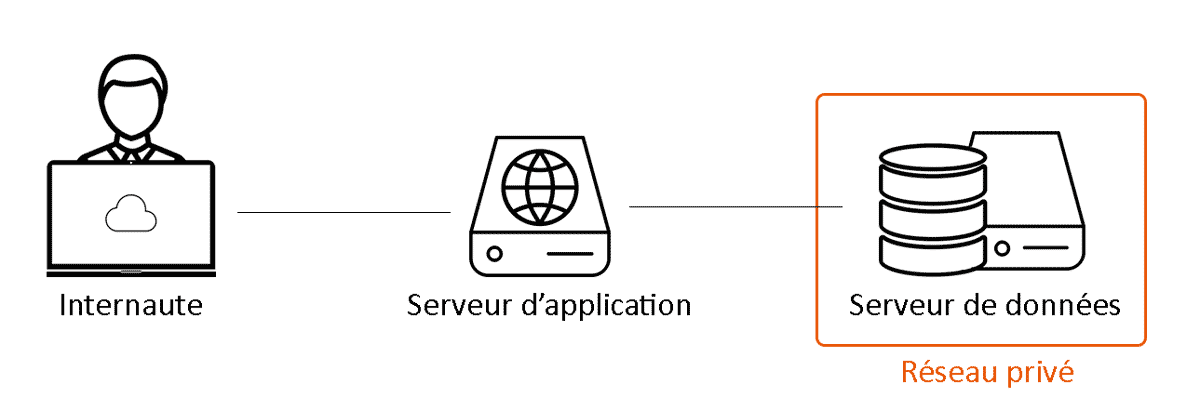

Une évolution de cette organisation est ce qu’on appelle l’architecture à trois niveaux ou trois couches (three tiers) mettant en jeu deux serveurs, l’un – le serveur d’application – faisant tourner le logiciel (traitement et présentation des données), l’autre – le serveur de stockage – dédié à la base de données[9] (Figure 5). Il est à noter que, pour des raisons de sécurité, l’information ne peut être stockée qu’une seule fois.

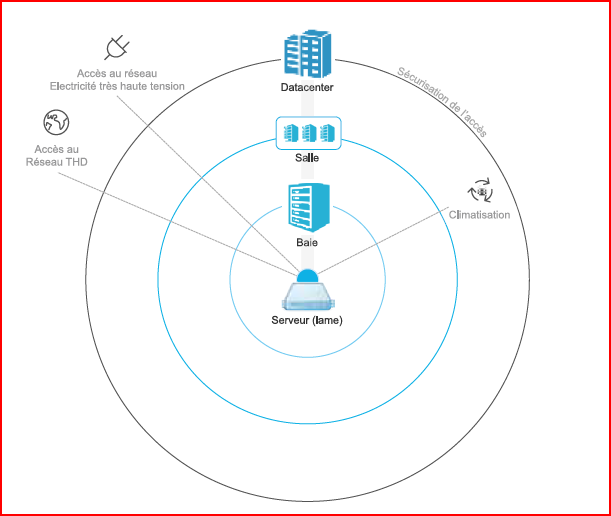

1.2. Les datacenters, infrastructures de serveurs

Les serveurs sont hébergés au sein d’infrastructures appelées en français centres de données et plus couramment maintenant datacenters qui se situent « au centre du système d’information et concentrent les données et les traitements informatiques critiques »[10].

Il en existe de toutes les tailles : dans son rapport sur la consommation d’énergie des centres de données, le Lawrence Berkeley National Laboratory (LBNL)[11]qualifie les plus petits, moins de 9m2, de placards (closet). Au dessus, jusqu’à 90 m2, il y a les salles sécurisées appelées salles serveurs (server room) (Figure 6) qui regroupent les ensembles de baies et les équipements réseau associés.

Le LBNL considère que les salles serveurs supérieures à 46 m2 peuvent mériter le nom de datacenter si elles disposent d’infrastructures techniques redondantes pour assurer la continuité de l’alimentation électrique, du refroidissement des serveurs et de l’accès au réseau de télécommunications : transformateurs, alimentations sans interruption, générateurs, armoires de climatisation, systèmes de distribution électrique.

Au-delà d’un certain seuil, il n’y a pas de limite car l’ensemble des salles sont intégrées dans un bâtiment spécialisé et sécurisé (Figure 7).

Le LBNL distingue les datacenters locaux (46 à 186 m2), les centres moyenne densité (186 à 1860 m2), les centres haute densité (au-delà de 1860 m2) et les centres géants, hyperscale, très haute densité qui peuvent comporter jusqu’à 8 modules de 4600 m2 chacun, soit environ 37 000m2 au total[12].

Concernant la continuité de service, l’Institut Uptime, organisme américain certificateur des datacenters, a défini quatre niveaux de disponibilité (Tier), allant du niveau I sans redondances au niveau IV permettant d’héberger des applications critiques avec une disponibilité de 99,99% [13]. Dans certains datacenters, l’ensemble de l’infrastructure consomme deux fois plus d’espace que celui destiné à héberger les équipements informatiques.

En France, la Caisse des Dépôts signale que « les nouvelles créations ou réhabilitations concernent en priorité des équipements de plus de 2 000 m2 » qualifiés de « haute densité »[14]. Et partout dans le monde certains datacenters dépassent maintenant la superficie de plusieurs stades de football[15], soit plus de 20 000 m2. Cependant, le LBNL précise qu’en 2007 la moitié des serveurs américains occupaient encore un espace inférieur à 90 m2.

Au final, les datacenters, dont la taille ne cesse d’augmenter, mettent en œuvre à travers le monde des capacités sans cesse grandissantes de stockage, de traitement et de mise à disposition en temps réel des informations. Mais les petits centres de données restent encore majoritaires.

1.3. Internalisation versus Cloud computing

Une autre distinction doit être prise en compte. Le LBNL (2016)[16] distingue deux types de datacenters: ceux qui sont internes aux entreprises et institutions (internal data centers) et ceux qui sont pourvoyeurs de services destinés à une clientèle (provider data centers), en plein développement.

Ainsi les organisations (entreprises, collectivités territoriales et autres) ont-elles maintenant le choix, pour gérer leur système d’information, entre l’acquisition d’un datacenter de taille adaptée à leurs besoins et le recours au Cloud computing qui est « un modèle d’accès à travers le réseau internet à un ensemble de ressources numériques, pouvant être allouées et libérées à la demande et pour lesquelles le fournisseur du service assure l’ensemble des activités de maintenance, de support et d’exploitation »[17].

Ce modèle de cloud computing offre des services de différentes natures :

- services d’hébergement à la demande (IaaS) : location de capacités de stockage ou de calcul auprès d’un fournisseur externe (housing) ;

- services de plateforme Cloud (PaaS) : location d’une plateforme prête à l’emploi et préconfigurée ;

- ou services de logiciel Cloud (SaaS) : location d’un logiciel prêt à l’emploi et préconfiguré.

L’intérêt pour le client, par rapport à l’acquisition d’un datacenter, est qu’il n’a plus la responsabilité des opérations de maintenance et d’exploitation du matériel et des logiciels, pris en charge par le fournisseur. Le client peut choisir entre deux options :

- Cloud privé : il bénéficiera d’un environnement informatique dédié au sein du datacenter,

- ou Cloud public : l’environnement sera mutualisé avec d’autres utilisateurs.

La Caisse des Dépôts identifiait en France 137 centres pourvoyeurs de services en 2014. Leur durée de vie est estimée entre 20 et 25 ans.

2. La consommation d’énergie des serveurs et datacenters

Au total, on observe que les supports du monde virtuel ont une réalité bien tangible. Celle-ci se traduit notamment par une consommation d’énergie grandissante.

2.1. Pas de sobriété numérique

Un article du journal Le Monde titrait de façon imagée en 2013 [18] « Les centres de données informatiques avalent des quantités croissantes d’énergie ». La consommation électrique mondiale des datacenters aurait en effet doublé entre 2000 et 2005[19]. ABB avance ainsi en 2016 le chiffre de 80 TWh[20], soit la production annuelle de presque dix réacteurs nucléaires de 1300 MW[21], et leur exploitation serait responsable de 2% des émissions de CO2.

Ces valeurs[22] sont probablement sous-estimées dans la mesure où la Commission européenne annonçait en 2010 que les datacenters consommaient environ 56 TWh d’électricité par an à travers l’Europe[23], soit l’ordre de grandeur de la consommation d’électricité de toute la région Auvergne Rhône-Alpes en 2015[24].L’étude du LBNL[25] avance pour sa part le chiffre de 70 TWh consommés aux États-Unis en 2014 dont la moitié par les 40 % de serveurs petits et moyens,, soit 1,8 % de la consommation électrique totale du pays, tandis que l’association environnementaliste NRDC estimait celle-ci à 76,4 TWh pour 2011[26].

En 2013, l’Institut Uptime, organisme certificateur des datacenters, estimait que près de 3 % de l’électricité produite dans le monde alimentait des datacenters[27]. Cette absence de sobriété a longtemps été renforcée par le surdimensionnement des installations pour faire face aux pointes de demande. Selon ABB[28], les datacenters ne sont utilisés qu’à 20 % de leur capacité. Le LBNL[29]donne le chiffre de 14 % en 2010 et précise que, lorsqu’un serveur ne traite aucune application, il consomme quand même 59 % de sa puissance maximale. Dis autrement, 35 % de l’énergie est consommée en pure perte. Le NRDC[30]évaluait en 2012 l’ensemble des pertes à 50 %.

2.2. Une croissance de la consommation qui s’infléchit

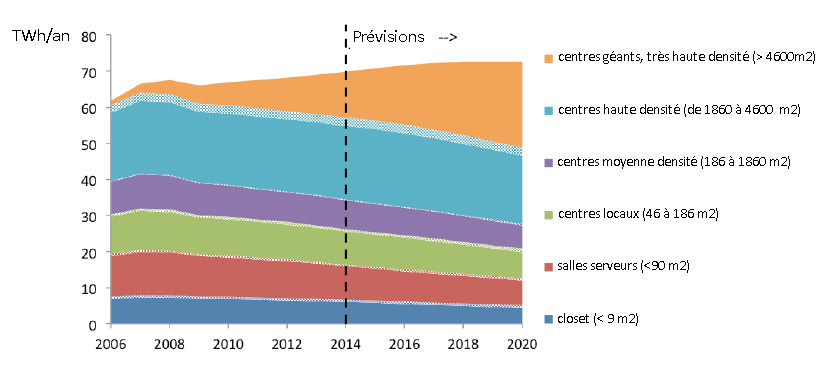

Le LBNL[31] souligne aussi (Figure 8) que la croissance de la consommation d’énergie des datacenters américains s’est infléchie au cours de la dernière décennie. Après avoir presque doublé entre 2000 et 2005, comme le nombre de serveurs, leur consommation d’énergie aurait continué à augmenter de 24 % entre 2005 et 2010 pour ne plus croître que de 4 % entre 2010 et 2014.

La première raison de cette inflexion est le ralentissement de la croissance du nombre de serveurs installés : il augmentait de 15 % par an entre 2000 et 2005, 5 % par an entre 2005 et 2010 et 3 % par an depuis. Ce constat s’explique principalement par le développement déjà évoqué de centres de données géants, hyperscale, dont la productivité et le taux d’utilisation sont optimisés. L’essentiel des nouveaux centres relèvent de cette catégorie. L’Institut Uptime[32]confirme que cette tendance forte est susceptible de s’amplifier dans les années à venir au niveau mondial.

L’augmentation de l’efficacité énergétique des datacenters constitue l’autre explication de l’inflexion constatée. Selon le LBNL, elle ne vient pas des 50 % de petits datacenters privés peu efficients qui représentent 60 % de la consommation électrique globale, mais des gros centres de données récents. Le journal Informatique news[33]note cependant qu’au niveau mondial « la demande en capacité de traitement informatique est telle que la demande en énergie continuera d’augmenter ».

2.3. La recherche d’efficacité énergétique des datacenters

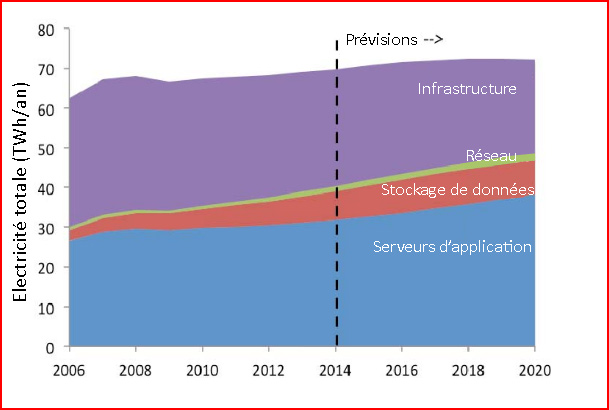

La consommation d’énergie des datacenters a deux origines : celle des systèmes informatiques (serveurs applicatifs, serveurs de stockage, ports d’accès au réseau) et celle des infrastructures (les équipements qui ne sont pas directement liés aux calculs, au stockage ou à la transmission des données, à savoir les systèmes de refroidissement, l’éclairage, les alimentations électriques ou la sécurité).

Selon le LBNL (2016), les serveurs d’application et les infrastructures se partagent à part égale plus de 85 % de la consommation d’énergie des datacenters (Figure 9), le reste étant principalement dévolu au stockage, l’accès au réseau étant marginal.

Pour le Syntec Numérique[34], la consommation électrique liée au stockage des données représente beaucoup plus, soit « environ 30% de celle d’un datacenter. Cette énergie est utilisée pour écrire et lire l’information mais aussi pour garder l’information inscrite et disponible sur l’emplacement qu’on lui a donné». L’amélioration des performances énergétiques des datacenters se situe à tous les niveaux :

- celle des serveurs vient des processeurs et autres composants et permet notamment une meilleure capacité à réduire la puissance appelée au repos ou en période de faible utilisation ;la mutualisation de plusieurs serveurs sur une seule machine, appelée virtualisation, par création de copies logicielles de plusieurs serveurs dont l’activité ne coïncide pas dans le temps, permet aussi des gains,

- les dispositifs de stockage bénéficient d’une augmentation des capacités de stockage sur chaque disque,

- les ports d’accès au réseau consomment moins d’énergie, la mutualisation des routages de l’information entre les utilisateurs et les serveurs de plusieurs réseaux sur un même équipement (câble cuivre ou fibre optique) engendre aussi des gains,

- et des conceptions et aménagements innovants minimisent les frais d’infrastructure, notamment de refroidissement.

Un des indicateurs d’efficacité énergétique d’un datacenter couramment utilisé est le PUE, Power Usage Effectiveness (PUE) [35],initialement proposé par l’organisation américaine GreenGrid, consortium d’industriels du monde informatique. C’est le ratio de l’énergie totale consommée par le datacenter sur l’énergie consommée par l’ensemble des systèmes informatiques : plus le PUE est proche de 1 et moins il y a d’énergie perdue dans les infrastructures. Un PUE sous 1,5 est considéré comme signe d’efficacité énergétique[36].

L’Institut Uptime l’évaluait à 2,5 en 2009 et estimait que la plupart des centres pourraient atteindre 1,6 en employant les meilleures pratiques du moment[37]. En 2013, la mutuelle d’assurance française MACIF a ainsi réussi à faire baisser le PUE de son nouveau centre de données créé en 2011 de 2,3 à 1,6[38]. Le LBNL rapporte pour sa part que le PUE moyen aux États-Unis s’élevait à 1,89 en 2010 ; il avait été estimé officiellement à 2 en 2007 bien que des études aient montré à l’époque que de nombreux centres avaient un PUE supérieur à 3. Les estimations du LBNL pour 2014 s’élèvent à 2,5 pour les closets, 2 pour les room servers, et descendent à 1,2 pour les datacenters hyperscale[39]. L’essentiel des consommations d’infrastructure est en fait lié au refroidissement des serveurs.

2.4. Le problème de l’échauffement des serveurs et sa résolution par refroidissement

Malheureusement, les serveurs créent de la chaleur par effet Joule qui est « un dégagement de chaleur provoqué par le passage d’un courant électrique dans un matériau conducteur lui opposant une résistance » [40].

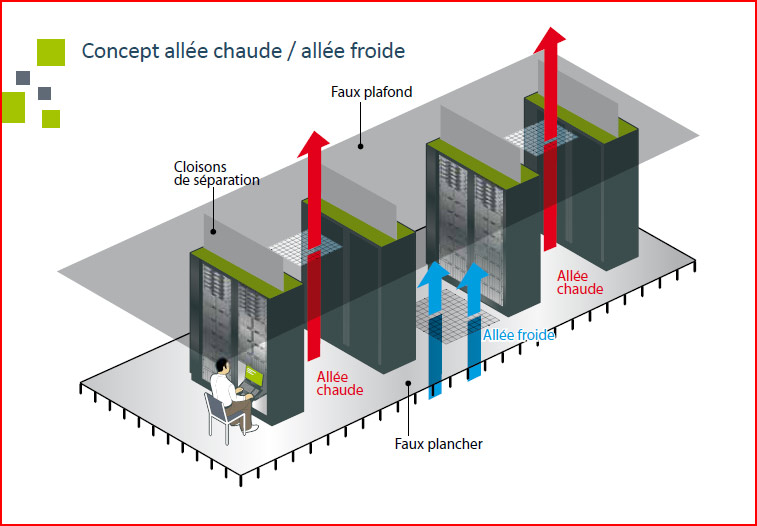

Le Syntec Numérique précise que l’énergie électrique consommée par les équipements informatiques est quasi intégralement convertie en chaleur et que la puissance dissipée est colossale. Cette chaleur constitue une lourde nuisance pour les équipements des datacenters qui ne pourraient plus fonctionner si elle n’était pas évacuée. Le modèle actuel dominant d’exploitation des salles serveurs consiste à transporter cette chaleur à l’extérieur par un système de conditionnement d’air qui assure aussi un niveau stable d’hygrométrie.

Le LBNL estime que les grands datacenters en cours de création actuellement ont la possibilité d’améliorer l’efficacité du refroidissement en utilisant des équipements plus efficaces ou le refroidissement liquide et en développant une meilleure gestion des flux d’air, ce qu’on appelle « l’urbanisation en allées froides et chaudes » (Figure 10). Frederic Bordage[41] évoque aussi le développement du confinement, c’est-à-dire la création de datacenters constitués de containers qui permettent de maximiser l’efficacité du refroidissement pour des installations de haute densité. (Figure 11).

Des solutions plus originales sont aussi envisagées pour limiter le besoin de refroidissement des datacenters hyperscale, comme l’implantation dans des zones géographiques froides : c’est le cas de celui de Facebook, 27000 m2, créé en 2012 à proximité du cercle arctique au nord de la Suède[42]. Il existe cependant d’autres solutions que le refroidissement.

3. La cogénération numérique

Le fonctionnement des datacenters souffre d’une double inefficacité énergétique : d’une part a chaleur dégagée constitue une énergie qui n’est pas valorisée, d’autre part de l’énergie supplémentaire est requise afin de lutter contre cette chaleur. Selon le document ABB déjà cité, le refroidissement des serveurs compte actuellement pour 30% de la facture énergétique de l’exploitation d’une salle. D’où l’idée d’évacuer la chaleur créée par les serveurs en lui trouvant une utilisation.

La préoccupation n’est pas nouvelle puisque Syndec (2011) mentionne l’existence d’un indicateur, l’ERF (Energy Reuse Factor) qui donne une idée du niveau de réutilisation de la chaleur produite par le datacenter. Il est défini comme le rapport entre l’énergie réutilisée et l’énergie totale consommée.

Et les expériences dans ce domaine se multiplient. Audrey Garric (2013) en cite quelques exemples[43], dont le plus important, celui du datacenter de la banque Natixis à Marne La Vallée qui alimente en eau à 55°C le réseau de chauffage urbain d’une zone en cours d’urbanisation et le centre nautique intercommunal du Val d’Europe. Plus récemment, Bertrand Lemaire (2017) annonce qu’Air France rénove un datacenter de 1000 m2 datant de 1977 ayant un PUE de 2,9 avec pour ambition de réutiliser la chaleur produite pour chauffer 8 500 m2 de bureaux[44].

Ce créneau attire aussi des starts-up, comme l’indique Claire Legros qui cite notamment l’entreprise Qarnot[45]. Elle propose des radiateurs connectés qui chauffent à la demande en réalisant des calculs informatiques pour des banques ou studios d’animation 3D, le tout piloté depuis une plate-forme basée à Montrouge.

À terme, certains imaginent qu’une partie des services numériques et de l’internet de demain seront ainsi hébergés dans des salles serveurs réparties sur les territoires qui assureront une partie des besoins énergétiques des villes. Comme on parle de cogénération lorsqu’on récupère à la fois l’électricité et la chaleur issues d’une centrale thermique classique, on peut parler ici de « cogénération numérique » puisqu’on vise la récupération simultanée de données numériques et de chaleur.

4. La solution innovante de Stimergy

C’est en partant d’un constat de dysfonctionnement que Christophe Perron a eu l’idée, en 2012, de créer l’entreprise Stimergy. Alors responsable de la salle serveur d’une entreprise, il a eu à gérer une panne de climatisation au sein du local. Lorsqu’il a ouvert la porte de la pièce, le thermomètre affichait déjà 40°C et les ventilateurs tournaient à plein régime pour tenter de refroidir les serveurs. Sans succès toutefois, car de nombreux serveurs s’étaient déjà éteints à cause de leur propre surchauffe. Il s’est alors aperçu de l’aberration actuelle dans la manière d’exploiter les datacenters.

4.1. L’invention d’une chaudière numérique

L’entreprise Stimergy a, pour sa part, développé sa propre technologie afin de récupérer la chaleur dégagée par les serveurs en vue de préchauffer de l’eau sanitaire, dont le besoin est constant sur toute l’année.

Les serveurs, considérés ainsi comme une source d’énergie, de même que l’uranium dans une centrale nucléaire, ou la lumière dans un système solaire thermique, sont immergés de façon étanche dans une cuve remplie d’huile qui fait office de circuit primaire de récupération de la chaleur (Figure 12) ; en effet, on ne peut pas immerger directement les serveurs dans le circuit d’eau sanitaire. L’huile utilisée est la même que celle dont se sert EDF pour ses transformateurs mais la tension et la température sont bien moins élevées. L’efficacité long terme des serveurs de la start-up grenobloise est garantie par une très faible maintenance, notamment en ce qui concerne le remplacement de l’huile. En effet, EDF change l’huile de ses transformateurs seulement tous les neufs ans.

Les cuves doivent être placées dans une pièce où s’organise l’approvisionnement en eau chaude d’un bâtiment (qu’il soit de logements, services, ou autre), et qui fera office de salle-serveur ou mini-datacenter. Un échangeur de chaleur permet alors de transférer les calories récupérées par l’huile à un circuit secondaire d’eau sanitaire dans le but de la préchauffer à une température allant de 45°C à 50°C. L’eau préchauffée est stockée dans un ballon tampon. Compte tenu du fonctionnement permanent des serveurs, cette solution est opérationnelle 365 jours par an. La température atteinte sera plus faible en hiver, où celle du réseau de distribution public peut descendre à 5°C, qu’en été où elle s’élève à 15°C.

Chaque serveur d’une puissance de 200 W IT[46] consomme annuellement[47] 1752 kWh, soit 1,7 MWh. Or il est possible, grâce au système de Stimergy, de récupérer chaque année 1 MWh de chaleur par serveur, soit près de 60 % de la chaleur dégagée. Autrement dit la consommation des serveurs est réduite de plus de moitié.

L’idée est ainsi d’installer des mini datacenters – d’une vingtaine de serveurs – dans la chaufferie de bâtiments résidentiels, tertiaires, ou de collectivités, et de les connecter au système de production d’eau chaude. Le PUE de la solution créée par Stimergy est de 1,1, ce qui correspond à un niveau de performance exceptionnel, supérieur à celui des datacenters hyperscale, alors que la moyenne européenne est proche de 2[48].

4.2. De l’idée à l’entreprise

La solution proposée par Stimergy a été développée à partir de juin 2013 grâce aux soutiens de plusieurs organismes publics, à commencer par les incubateurs : GRAIN[49], pour GRenoble Alpes Incubation, organisme local de détection et d’accompagnement de projets de création d’entreprises innovantes, mais aussi à partir de 2014 l’accélérateur Kic InnoEnergy[50] (Communauté de la connaissance et de l’innovation dans le domaine de l’énergie), émanation de l’EIT (European Institute of innovation and Technology)[51], qui est un organisme de l’Union européenne visant à renforcer la capacité d’innovation de l’Europe en rassemblant entreprises, secteur éducatif et de la recherche dans une logique transfrontalière. L’une des implantations de la Kic InnoEnergy se trouve à Grenoble[52]. Ces organismes ont aidé Stimergy dans la phase d’expérimentation et de mise au point de son business modèle.

Stimergy a ainsi rapidement été sélectionnée pour s’installer dans la pépinière d’entreprises d’Inovallée, baptisée Le Tarmac, qui a ouvert ses portes en novembre 2013 à Meylan près de Grenoble[53]. Elle est maintenant installée à Monteynard. L’INRIA, établissement public de recherche dédié aux sciences du numérique[54], est intervenu sur le développement du système informatique et la question de la gestion de la charge des serveurs.

L’Opac 38, Office public de l’habitat[55], a facilité l’étape du prototypage en donnant accès à son système de chauffage central, pour l’installation d’un cluster ou ensemble de 1kW IT qui est en fonction depuis juillet 2013 et contribue à l’alimentation en eau chaude de 29 logements sociaux. L’université Jean Moulin – Lyon 3 accueille un équipement de même puissance depuis janvier 2015[56] qui a permis à la fois de mettre en place une solution de Desktop Virtuel (une interface permettant d’accéder à distance à un système informatique à destination de ses étudiants) et d’alimenter en eau chaude les douches d’un gymnase (Figure 13).

Côté entreprises[57], la jeune société a également très vite compté comme partenaire installateur une entreprise de chauffage, Pasini. Elle a ensuite remporté le concours EDF Energie Intelligente en novembre 2013, puis a été nominée à EDF PULSE 2016. Elle a rencontré l’entreprise Nexity, promoteur et gestionnaire immobilier de renom, dans le cadre d’un concours sur le bâtiment durable.

Selon son PDG, Christophe Perron, l’Aide au Développement Expérimental (ADE) du Département de l’Isère a ensuite été déterminante dans le développement de Stimergy:

« La subvention ADE nous a permis de convaincre Nexity de mettre en place une installation dans une de leur résidence étudiants. Séduit par notre produit, la direction de Nexity nous a présenté à un premier fond d’amorçage cleantech »[58]. Finalement, Stimergy a levé 1,25 M€ auprès de deux fonds d’investissement en 2016 [59] après avoir installé un cluster de 4 kW IT dans une résidence étudiante de Nexity de Grenoble, qui fonctionne depuis mars 2016 et qui montre un gain de plus de 15 kWh/m2/an[60].

Il s’agit là d’une success story qui montre l’importance de l’accompagnement public au démarrage des entreprises innovantes, pour franchir ce qu’on appelle l’equity gap ou « trou de financement » avant de parvenir au point d’intéresser les fonds d’investissement. Stimergy a en outre pu mobiliser des acteurs économiques locaux pour son expérimentation, tels que chaudronniers, automaticiens, câbleurs et chauffagistes. Elle peut, grâce au financement obtenu, commencer à industrialiser la fabrication de son système servant à récupérer la chaleur des serveurs informatiques pour produire de l’eau chaude et signer des contrats d’installation de ses datacenters.

Stimergy a en outre reçu au Salon POLLUTEC 2016 le trophée de l’entreprise circulaire lors de la 3ème édition du concours organisé par l’Institut de l’économie circulaire[61].

4.3. Une solution profitable aussi bien au client de datacenter qu’à l’utilisateur d’eau chaude

Les serveurs développés par Stimergy peuvent profiter à plusieurs types de profils : le client informatique, l’utilisateur de la chaleur et le client qui utilise à la fois les capacités informatiques et la chaleur. Leur déploiement potentiel s’inscrit dans le cadre du développement de l’économie numérique, en misant sur l’intégration de petits datacenters plus sobres en énergie au sein du tissu urbain. Ces datacenters peuvent être internes aux organisations ou externalisés, fournisseurs de services via le Cloud, comme indiqué plus haut. Ainsi le modèle économique proposé par Stimergy s’est-il adapté à ces différentes perspectives.

L’utilisateur de la chaleur est l’entité qui bénéficie d’une eau chauffée grâce à l’installation d’une salle serveur Stimergy dans ses locaux. Aujourd’hui, plusieurs bâtiments sont équipés de cette solution en région Rhône-Alpes. L’entreprise a également signé plusieurs contrats d’installation ailleurs en France, notamment pour équiper un bâtiment résidentiel de 40 logements à Nantes[62], ainsi que la piscine de la Butte aux Cailles dans le 13ème arrondissement de Paris[63], ce qui la place comme un des leaders français sur les micro-datacenters énergétiquement performants[64].

Cette prestation est proposée aux hôteliers, gestionnaires d’immeubles ou de résidences, exploitants de chaufferie, dont les biens sont constitués d’une vingtaine de logements et plus. L’accueil d’une chaudière numérique, qui peut être constituée de 20 à 40 serveurs, leur permet de préchauffer l’eau de 20 à 40 logements de manière à couvrir 30 à 60 % des besoins en eau chaude sanitaire[65]. En outre ce système de récupération de chaleur est considéré en France comme un équipement de production d’énergie renouvelable d’après la loi TECV n°2015-992 du 17 août 2015[66]. Enfin, l’aspect social n’est pas absent, puisque Stimergy se propose notamment de fournir de l’eau chaude à moindre coût à une population en difficulté en disposant ses salles serveurs au sein d’installations accueillant des logements sociaux[67].

Pour les clients intéressés à la fois par des capacités informatiques et de la chaleur, Stimergy propose un Cloud privé, comme celui mis en place à l’université Lyon 3. Les infrastructures bénéficiant de cette solution jouissent d’un retour sur investissement inférieur à trois ans, le surcoût d’une salle serveur Stimergy étant amorti par la valorisation de la chaleur dégagée par les serveurs. Les prestations offertes par Stimergy comprennent la conception de la salle serveurs, sa réalisation, son exploitation, sa maintenance.

À destination des utilisateurs numériques exclusifs, Stimery propose un Cloud public à ancrage territorial, via l’accès à ses racks de serveurs sobres en énergie installés dans les locaux sécurisés évoqués précédemment. Le client informatique loue et utilise donc les salles serveurs de Stimergy, fonctionnelles 24h sur 24, 7 jours sur 7, en y stockant ses données, en y hébergeant ses applications ou simplement en utilisant de la puissance de calcul.

L’utilisateur numérique contribue donc à alimenter la chaudière numérique tout en s’assurant une diminution du coût du stockage de ses données grâce à la suppression du coût de refroidissement des serveurs. Il s’assure d’autre part d’une grande protection et accessibilité de ses données et applications, du fait de la possibilité de redondances dans plusieurs datacenters de Stimergy ou d’éclater les données sensibles, tout en restant ancré dans un territoire délimité. Les clients peuvent être aussi bien des TPE, des PME, que de grosses entreprises, la résilience des installations étant équivalente à un datacenter de type Tier IV.

À terme, l’ambition de l’entreprise est d’installer des salles serveurs de 10 à 100 kVA interconnectées par de la fibre optique de manière à former un datacenter distribué et décentralisé, dont profitera toute l’économie nationale.

Notes et références

[1]Blog du Modérateur. (2017).État des lieux 2017 : l’usage d’Internet, des réseaux sociaux, des messageries et du mobile, 24 janvier 2017. Disponible sur :http://www.blogdumoderateur.com/etat-lieux-2017-internet-reseaux-sociaux/ [Consulté le 31/01/2017]

[2]Adgensite (2017) Chiffres. Disponible sur : http://www.adgensite.com/category/actualites-2/chiffres/ [Consulté le 31/01/2017]

[3] Voir Syntec Numérique (2011).Datacenters et développement durable, état de l’art et perspectives. Paris : Syntec Numérique, syndicat professionnel du numérique français (livre vert) 39p Disponible sur : http://gblogs.cisco.com/fr-datacenter/2011/07/27/datacenters-et-developement-durable-6eme-livre-vert-du-syntec-numerique/[Consulté le 31/01/2017]

[4]Voir GogueyEric. Dictionnaire de l’informatique et de l’internet. Disponible sur : http://www.dicofr.com/ [Consulté le 08/02/2017]

[5]Voir FranceTerme, site consacré aux termes recommandés au Journal officiel de la République française. http://www.culture.fr/franceterme

[6]GogueyEric.Op.cit.

[7] Syntec Numérique (2011). Op cit.

[8] GogueyEric.Op.cit.

[9] Wikipedia Architecture trios tiershttps://fr.wikipedia.org/wiki/Architecture_trois_tiers [Consulté le 08/02/2017]

[10] Syntec Numérique (2011), op. cit.

[11] Shehabi A., Smith S.J., Horner N., Azevedo I., Brown R., Koomey J., Masanet E., Sartor D., Herrlin M., Lintner W. (2016) . United States Data Center Energy Usage Report. Berkeley, California: Lawrence Berkeley National Laboratory, LBNL, june. 56p. Disponible sur: https://eta.lbl.gov/publications/united-states-data-center-energy and https://datacenters.lbl.gov/resources/united%E2%80%90states%E2%80%90data%E2%80%90center%E2%80%90energy%E2%80%90usage [Consulté le 31/01/2017] Le document sera référencé dans la suite de l’article LBNL (2016)

[12] Le caractère surprenant des valeurs bornes vient de la conversion des unités de mesures américaines (le pied-carré) en mètres-carrés. 1 ft2 = 0,0929 m2. Les bornes originales sont de 500, 2000, 20 000 et 400 000 ft2.

[13] Syntec Numérique (2011). Op. cit.

[14] Caisse des Dépôts (2015).Guide sur le cloud computing et les datacenters à l’attention des collectivités locales. 137p. Disponible sur : http://www.entreprises.gouv.fr/numerique/guide-du-cloud-computing-et-des-datacenters [Consulté le 31/01/2017]

[15] Syntec Numérique (2011). Op. cit.

[16]LBNL (2016). Op. cit.

[17] Caisse des Dépôts (2015).Op. cit.

[18]Garric Audrey (2013). Les centres de données informatiques avalent des quantités croissantes d’énergie. Le Monde. 01/07/2013 Disponible sur http://www.lemonde.fr/planete/article/2013/07/01/les-centres-de-donnees-informatiques-gros-consommateurs-d-energie_3439768_3244.html[Consulté le 31/01/2017]

[19] Syntec Numérique (2011), op. cit.

[20]ABB Group (2016). L’impact énergétique des data centers. Disponible sur : http://new.abb.com/fr/datacenters [Consulté le 31/01/2017] 80 térawatt-heures = 80 109 kWh = 80 millions de mégawatt-heures.

[21] Calculs propres à partir des données françaises disponibles sur http://www.statistiques.developpement-durable.gouv.fr/energie-climat/966.html. C’est aussi plus que toute la consommation d’électricité de la région Ile de France et 14 % de la production électrique française de 2015.

[22]Les données restent de toute façon imprécises dans la mesure où elles ne font pas l’objet d’une collecte systématique et sont reconstituées à partir d’estimations et d’enquêtes.

[23]European Commission (2010) Stratégie numérique: de grandes entreprises du secteur des TIC rallient l’initiative de la Commission européenne en faveur d’une réduction de la consommation d’électricité (Press release) 28 sept. Disponible sur : http://europa.eu/rapid/press-release_IP-10-1185_fr.htm?locale=en[Consulté le 31/01/2017]

[24] RTE (2016) Bilan électrique 2015 Auvergne Rhône-Alpes.12 avril. Disponible sur : http://www.rte-france.com/fr/actualite/bilan-electrique-2015-auvergne-rhone-alpes [Consulté le 31/01/2017]

[25] LBNL (2016). Op. cit.

[26] Natural Resources Defence Council (2014) Data Center Efficiency Assessment. New-York: NRDC, 34p. Disponible sur: https://www.nrdc.org/sites/default/files/data-center-efficiency-assessment-IP.pdf[Consulté le 02/02/2017]

[27]Voir Preimesberger Chris (2013)Intel’s Low-Power Atom Chip Making Way Into Data Centers. eweek.com, 06/09/2013 http://www.eweek.com/storage/slideshows/intels-low-power-atom-chip-making-way-into-data-centers.html?kc=EWKNLESB09082013STR1&dni=77668363&rni=24932747#sthash.i11VamNP.dpuf

[28] ABB Group (2016). Op. cit.

[29] LBNL (2016). Op cit, p26

[30] Delforge Pierre (2012). Are There Ghosts in Your Closet? Saving Wasted Energy in Computer Server Rooms. Energy facts. NRDC, feb, 4p. Disponible sur: https://www.nrdc.org/sites/default/files/Saving-Energy-Server-Rooms-FS.pdf [Consulté le 02/02/2017]

[31] LBNL (2016). Op cit.

[32]Matt Stansberry (2016). 2016 data center industry survey result. Up Time Institute. 11p. Disponible sur: https://uptimeinstitute.com/ [Consulté le 02/02/2017]

[33] Guy Hervier (2016) Le cloud ralentit la consommation d’électricité. Informatiquenews,29/06/2016. Disponible sur http://www.informatiquenews.fr/cloud-ralentit-consommation-delectricite-47732 [Consulté le 02/02/2017]

[34]Syntec Numérique (2011).Op. cit.

[35] Voir SearchDataCenter.com Disponible sur : http://searchdatacenter.techtarget.com/definition/power-usage-effectiveness-PUE[Consulté le 02/02/2017] et Simonnet Alexandre (2010). Le « Power Usage Effectiveness », mesure désormais de référence pour l’efficacité énergétique des « data centers », latribune.fr, 8/04. Disponible sur : http://www.latribune.fr/green-business/l-actualite/20100408trib000496569/le-power-usage-effectiveness-mesure-desormais-de-reference-pour-l-efficacite-energetique-des-data-centers.html [Consulté le 02/02/2017]

[36] Simonnet Alexandre (2010).Op. cit.

[37] idem

[38] Lemaire Bertrand (2014). La Macif réduit de 80 000 euros la facture d’un datacenter. Lemondeinformatique.fr, 6 mai. Disponible sur : http://www.lemondeinformatique.fr/actualites/lire-la-macif-reduit-de-80-000-euros-la-facture-d-electricite-d-un-datacenter-53490.html [Consulté le 02/02/2017]

[39] Op.cit, 2016, pp. 23 et 26.

[40]Connaissances des Énergies (2013). Qu’est-ce que l’effet Joule ?Disponible sur : http://www.connaissancedesenergies.org/qu-est-ce-que-l-effet-joule-130708 [Consulté le 31/01/2016].

[41]Bordage Frederic (2016) La consommation électrique des centres de données se stabilise. GreenIT19/07/2016 Disponible sur : https://www.greenit.fr/2016/07/19/consommation-electrique-centres-de-donnees-se-stabilise/ [Consulté le 02/02/2017]

[42] Voir Caisse des Dépôts (2015)

[43]Garric Audrey (2013). Se chauffer grâce à l’énergie des serveurs informatiques. 02/07. Disponible sur : http://www.lemonde.fr/planete/article/2013/07/01/se-chauffer-grace-a-l-energie-des-serveurs-informatiques_3439685_3244.html#YhOLd97IA4oEClOi.99 [Consulté le 04/02/2017]

[44]Lemaire Bertrand (2017) 8500 m2 chauffés grâce au datacenter d’Air France. lemondeinformatique.fr, 10 janvier. Disponible sur : http://www.lemondeinformatique.fr/actualites/lire-8-500-m%C2%B2-de-bureaux-chauffes-grace-au-datacenter-d-air-france-67013.html [Consulté le 02/02/2017]

[45]Legros Claire (2016) Des pionniers qui veulent chauffer les villes avec nos ordinateurs. Le Monde. 07/01/2016 Disponible sur http://www.lemonde.fr/smart-cities/article/2016/01/07/ces-pionniers-qui-veulent-chauffer-les-villes-avec-nos-ordinateurs_4843208_4811534.html?xtmc=data_centre_energie&xtcr=9[Consulté le 31/01/2017]

[46] Puissance électrique appelée par le serveur à pleine charge (IT : Information Technologies)

[47] Une année compte 24*365 = 8760 heures

[48] Bouëdec Roland (2016) Stimergy vend du cloud … et de l’eau chaude. Lemag-numerique.com, 15 juin. Disponible sur : http://www.lemag-numerique.com/2016/06/stimergy-vend-cloud-de-leau-chaude-8924 [Consulté le 22/02/2017]

[49] GRAIN http://www.grenoble-isere.com/fr/les-accelerateurs-du-transfert-technologique

[50] Kic InnoEnergy ( Knowledge Innovation Community InnoEnergy) http://www.innoenergy.com/news-list/?s=stimergy

[51] EIT (European Institute of innovation and Technology) http://eit.europa.eu/fr/in-your-language

[52] KIC InnoEnergy France http://www.innoenergy.com/office/france/

[53] Estrangin Matthieu (2013). Six entreprises déjà sélectionnées pour intégrer la pépinière Isère Sud/Meylan. Ledauphine.com 20/09. Disponible sur : http://www.ledauphine.com/isere-sud/2013/09/12/six-entreprises-deja-selectionnees-pour-integrer-la-pepiniere [Consulté le 22/02/2017]

[54] Site de l’INRIA https://www.inria.fr/ [Consulté le 22/02/2017]

[55] Site de l’OPAC 38 http://www.opac38.fr/ [Consulté le 22/02/2017]

[56] Thebault Déborah (2016). Stimergy, Nantes Digital Week. Disponible sur: https://fr.slideshare.net/Atlanpole/stimergy-66213101 [Consulté le 22/02/2017]

[57] Rey Marianne (2014) Stimergy: un cloud qui fournit l’eau chaude. lexpress.fr, 17/01. Disponible sur : http://lentreprise.lexpress.fr/creation-entreprise/idees-business/stimergy-un-cloud-qui-fournit-l-eau-chaude_1515463.html [Consulté le 22/02/2017]

[58] AEPI (2016a). L’aide au développement expérimental (ADE) du Département : retour sur la success story de la start-up Stimergy qui lève 1.25 M d’€ pour accélérer sa croissance. 26 janvier. Disponible sur : http://www.grenoble-isere.com/fr/news/actualites/l-aide-au-developpement-experimental-ade-du-departement-retour-sur-la-success-story-de-la-start [Consulté le 22/02/2017]

[59]AEPI (2016b). Stimergy lève 1,25 million d’euros. 10 mars. Disponible sur : http://www.grenoble-isere.com/fr/news/economie-a-grenoble-et-en-isere/stimergy-leve-1-25-million-d-euros [Consulté le 22/02/2017]

[60] Thebault Déborah (2016). Op. cit.

[61] POLLUTEC 2016 Trophées de l’économie circulaire Disponible sur : http://www.pollutec.com/Visiter/Remise-de-Prix-et-Trophees/Trophees-de-l-economie-circulaire.htm [Consulté le 22/02/2017]

[62] Bouëdec Roland (2016). Op. cit.

[63]InnoEnergy (2016) Stimergy’s IT servers will heat the indoor swimming pool at la Butte-aux-Cailles in Paris, 17 mars Disponible sur: http://www.innoenergy.com/stimergys-it-servers-will-heat-the-indoor-swimming-pool-at-la-butte-aux-cailles-in-paris/ [Consulté le 22/02/2017]

[64] AEPI (2016b). Op. cit.

[65] Stimergy, video de présentation. Disponible sur : https://www.youtube.com/watch?v=g6nuigMGGPQ&feature=youtu.be [Consulté le 22/02/2017]

[66]Voir Legifrance (2015) LOI n° 2015-992 du 17 août 2015 relative à la transition énergétique pour la croissance verte https://www.legifrance.gouv.fr/affichTexte.do?cidTexte=JORFTEXT000031044385&categorieLien=id

[67] L’INSEE estimait en 2011 à 5,9 millions le nombre de ménages en situation de précarité énergétique. INSEE Première, n°1351, mai 2011 Disponible sur : https://www.insee.fr/fr/statistiques/1280942 [Consulté le 22/02/2017]

Bibliographie complémentaire

Caisse des Dépots (2015) Guide sur le cloud computing et les datacenters à l’attention des collectivités locales. 137p. Disponible sur : http://www.entreprises.gouv.fr/numerique/guide-du-cloud-computing-et-des-datacenters [Consulté le 31/01/2017]

Center of Expertise for Energy Efficiency in Data Centers, US Department of Energy https://datacenters.lbl.gov/

Shehabi A., Smith S.J., Horner N., Azevedo I., Brown R., Koomey J., Masanet E., Sartor D., Herrlin M., Lintner W. (2016) . United States Data Center Energy Usage Report. Berkeley, California: Lawrence Berkeley National Laboratory, LBNL, june. 56p. Disponible sur: https://eta.lbl.gov/publications/united-states-data-center-energy and https://datacenters.lbl.gov/resources/united%E2%80%90states%E2%80%90data%E2%80%90center%E2%80%90energy%E2%80%90usage [Consulté le 31/01/2017]

Site de l’entreprise Stimergy : http://www.stimergy.net/

Syntec Numérique (2011).Datacenters et développement durable, état de l’art et perspectives. Paris : Syntec Numérique, syndicat professionnel du numérique français (livre vert) 39p Disponible sur : http://gblogs.cisco.com/fr-datacenter/2011/07/27/datacenters-et-developement-durable-6eme-livre-vert-du-syntec-numerique/ [Consulté le 31/01/2017]

L’Encyclopédie de l’Énergie est publiée par l’Association des Encyclopédies de l’Environnement et de l’Énergie (www.a3e.fr), contractuellement liée à l’université Grenoble Alpes et à Grenoble INP, et parrainée par l’Académie des sciences.

Pour citer cet article, merci de mentionner le nom de l’auteur, le titre de l’article et son URL sur le site de l’Encyclopédie de l’Énergie.

Les articles de l’Encyclopédie de l’Énergie sont mis à disposition selon les termes de la licence Creative Commons Attribution – Pas d’Utilisation Commerciale – Pas de Modification 4.0 International.

![Fig. 3 : L’intérieur d’un serveur lame – Source : By Robert Kloosterhuis [CC BY-SA 2.0 (http://creativecommons.org/licenses/by-sa/2.0)], via Wikimedia Commons](https://www.encyclopedie-energie.org/wp-content/uploads/2017/03/art126_figure3_serveur-lame.jpg)

![Fig. 6 : L’intérieur d’une salle serveurs – source : By BalticServers.com (I took this photo) [GFDL (http://www.gnu.org/copyleft/fdl.html) or CC BY-SA 3.0 (http://creativecommons.org/licenses/by-sa/3.0)], via Wikimedia Commons](https://www.encyclopedie-energie.org/wp-content/uploads/2017/03/art126_figure6_salle-serveurs.jpg)